Intelligente Allmende

Einleitung

Intelligente Allmende: Die begehbare Installation in der Orangerie des Rüschhauses verbindet Mensch, Natur und Technologie und fragt nach der Intelligenz des Gemeinguts – nach der Herstellung, Speicherung und Verfügbarkeit von Wissen.

Das Gewächshaus wird Schauplatz einer interaktiven Installation. Die Installation ist Teilergebnis einer bislang eineinhalbjährigen künstlerischen Forschungsarbeit von Fabian Raith, Franziska Winkler und Leoni Voegelin und Ergebnis einer Zusammenarbeit mit Kunstschaffenden aus verschiedenen Bereichen. Zu neuen Verbindungen von Technologie, Poesie und Natur.

In der Installation werden Poesien von hörenden und tauben Künstler*innen, eine bilderzeugende künstliche Intelligenz und eine interaktive Rauminstallation miteinander verbunden. Die einzelnen Elemente beziehen sich dabei aufeinander und bilden einen Hybrid aus Poesie, Objekt- und Medienkunst.

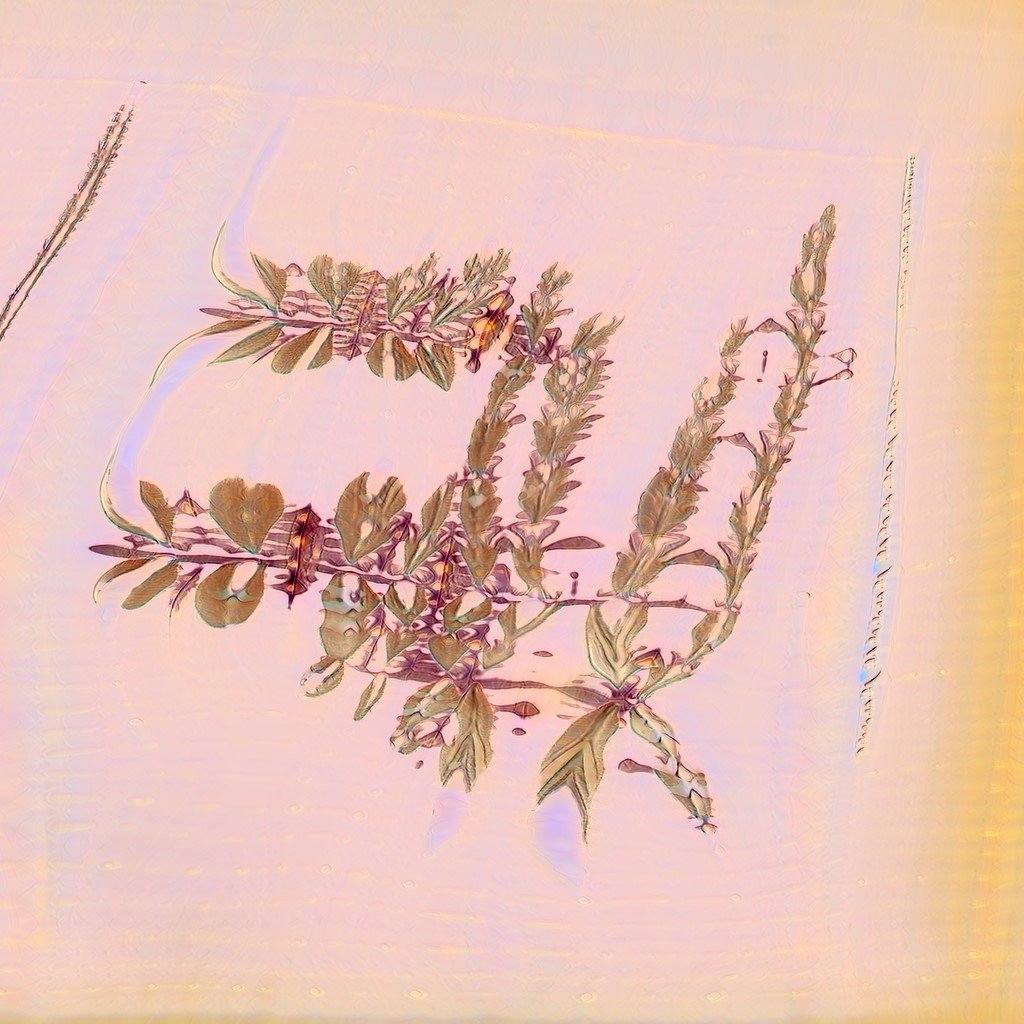

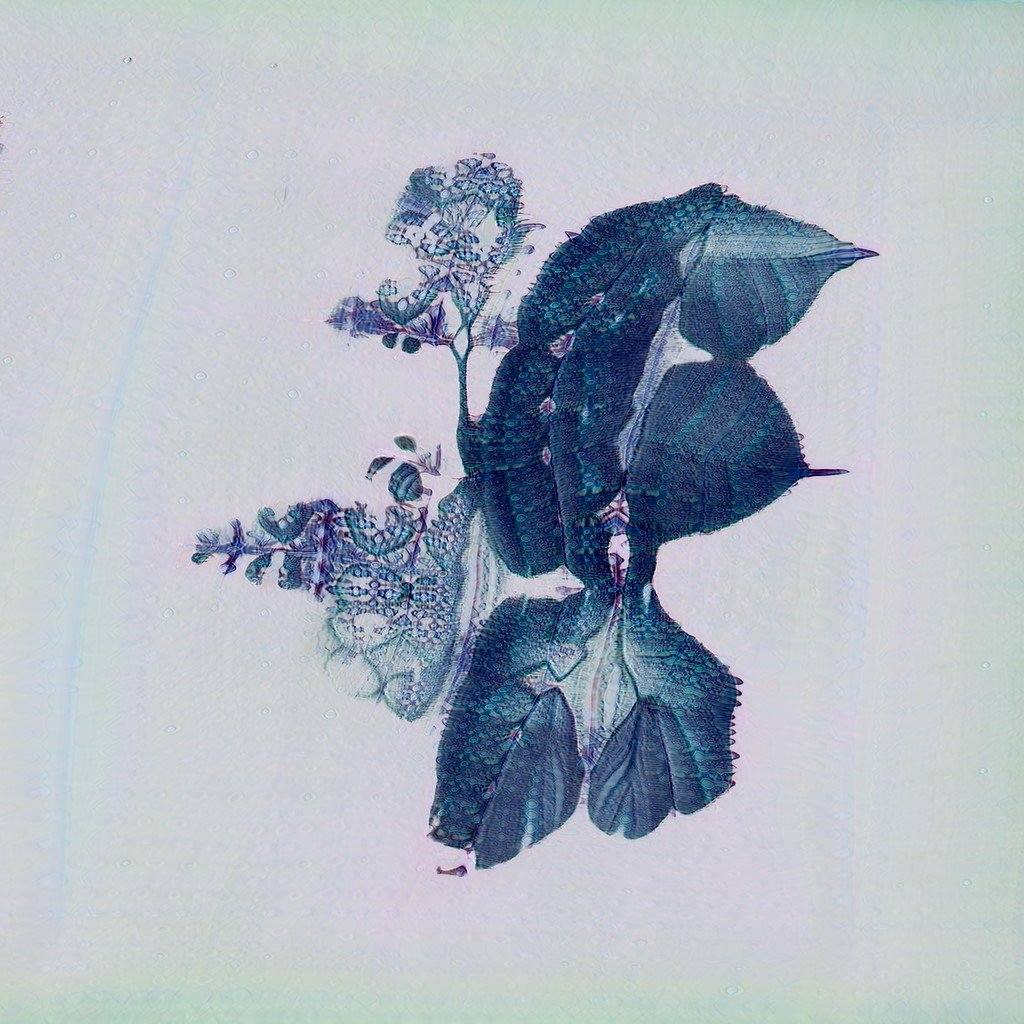

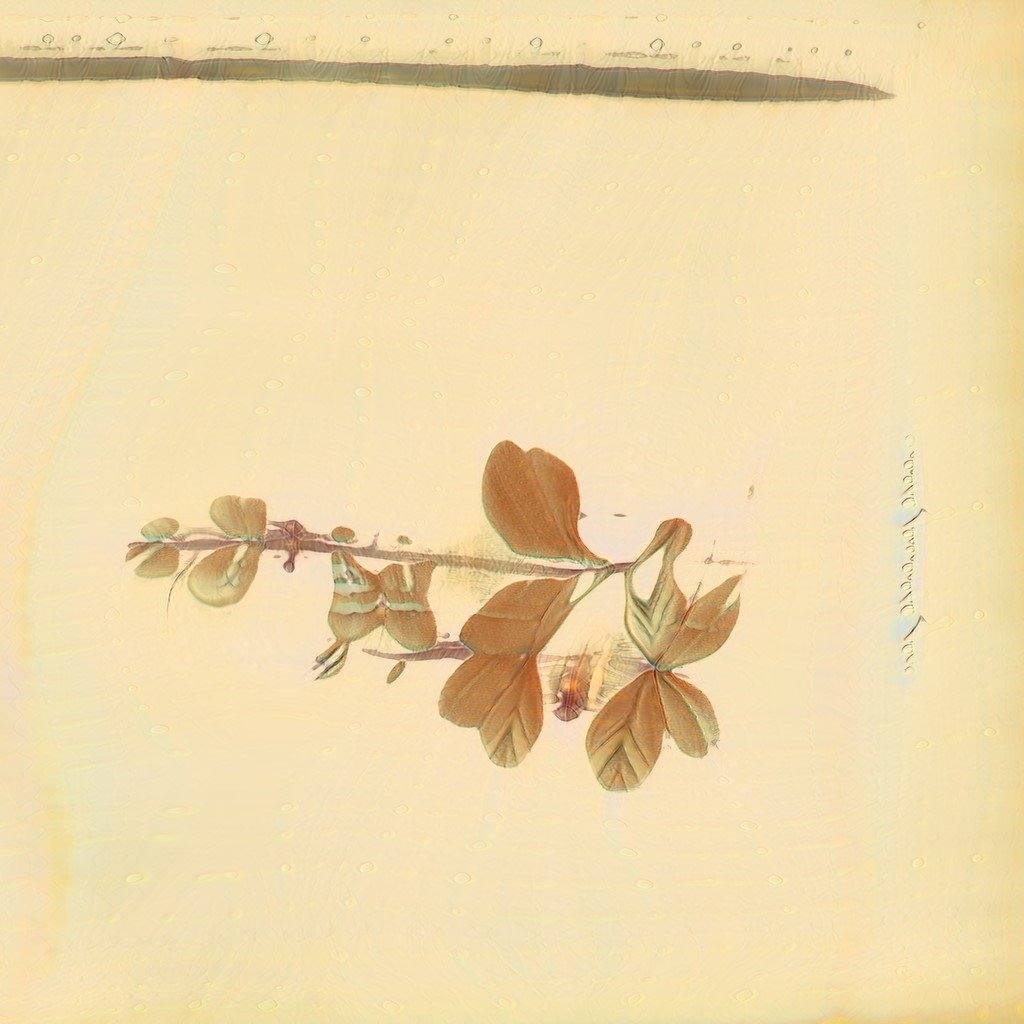

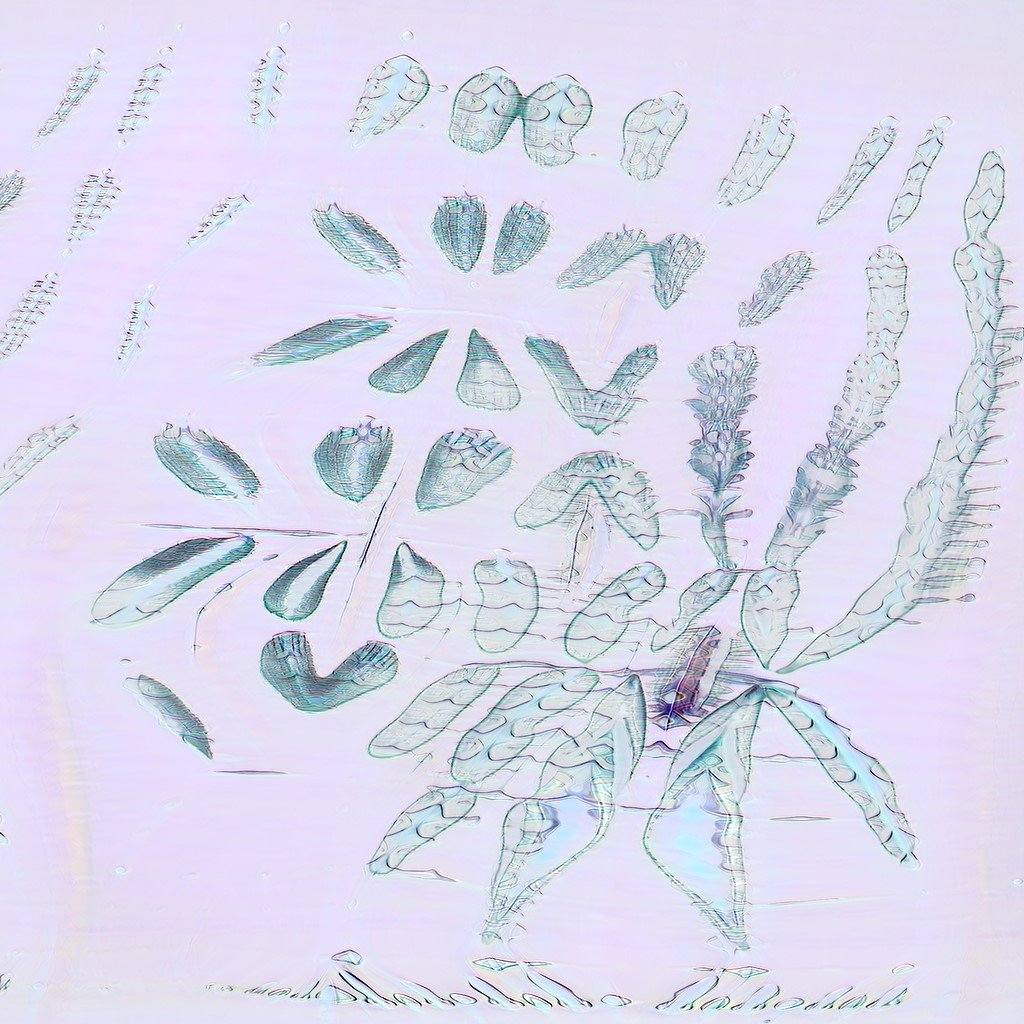

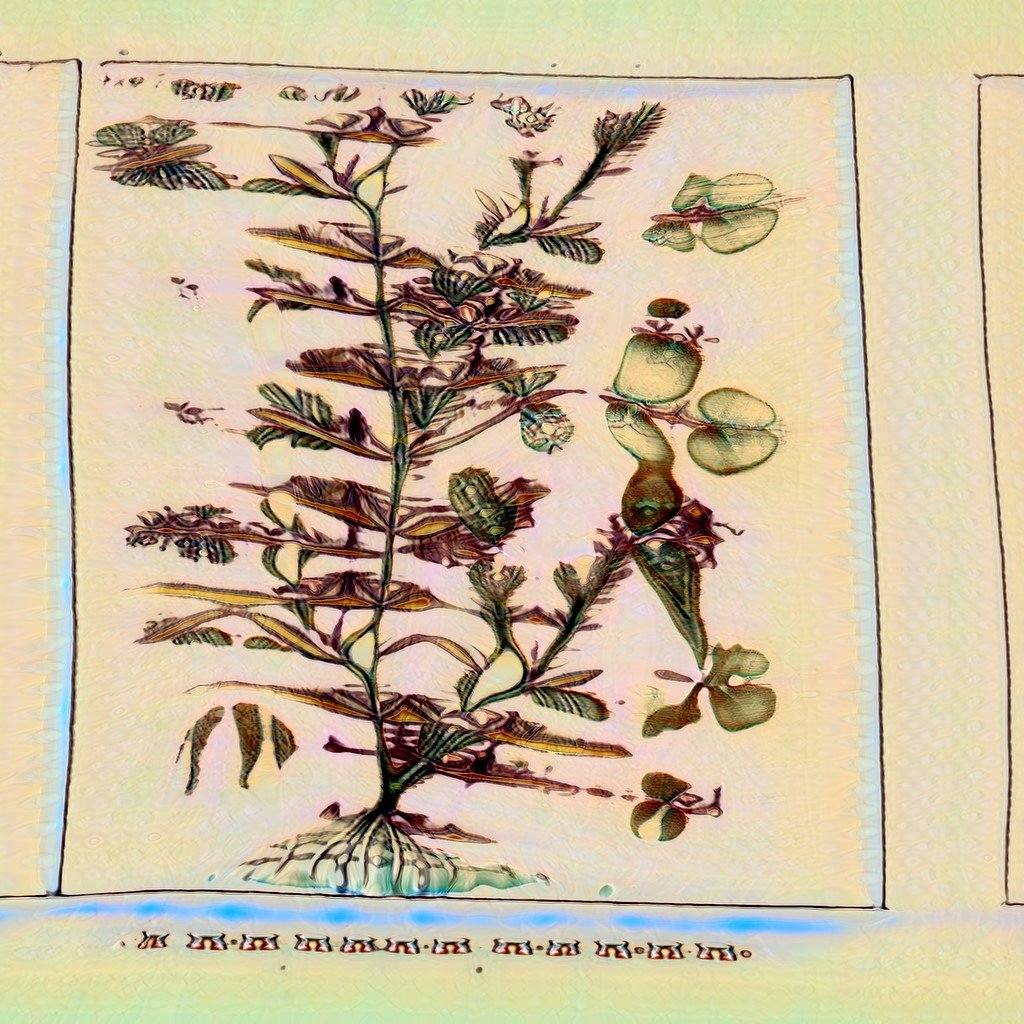

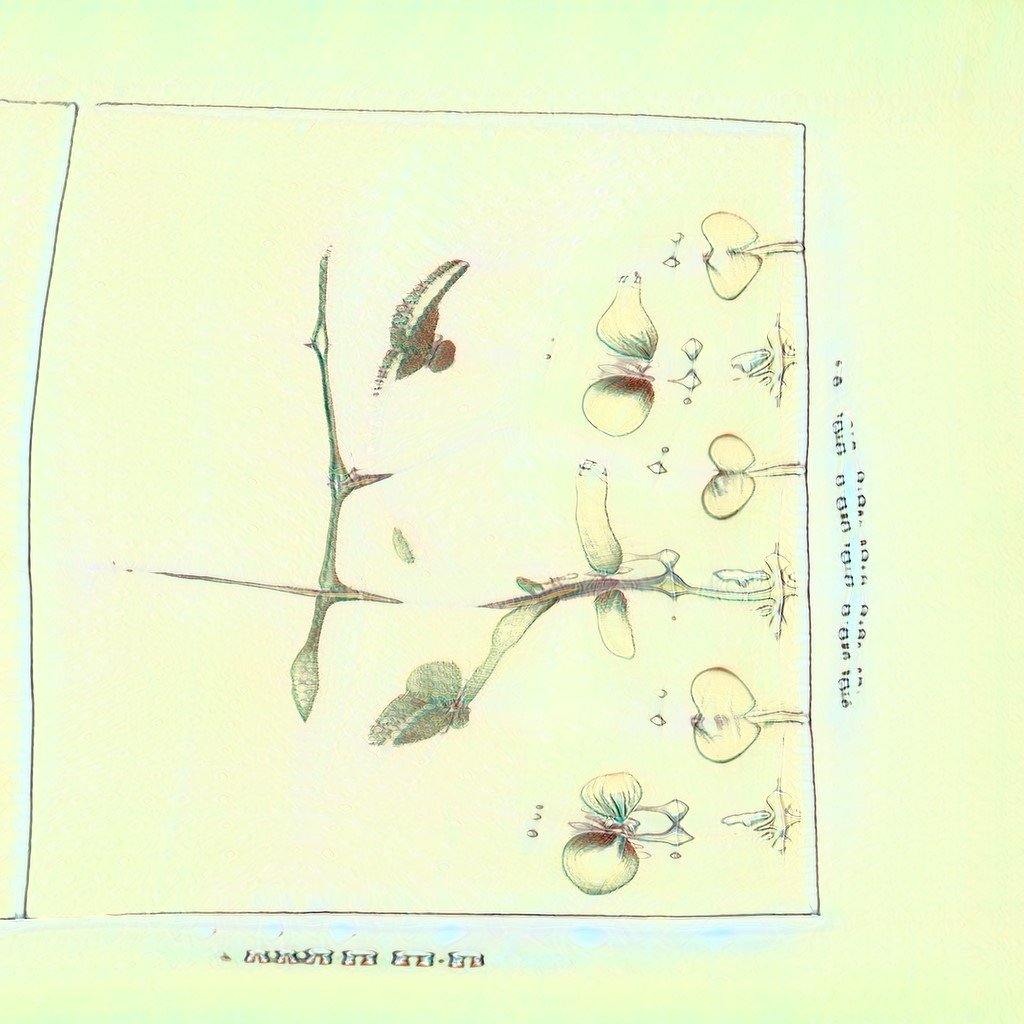

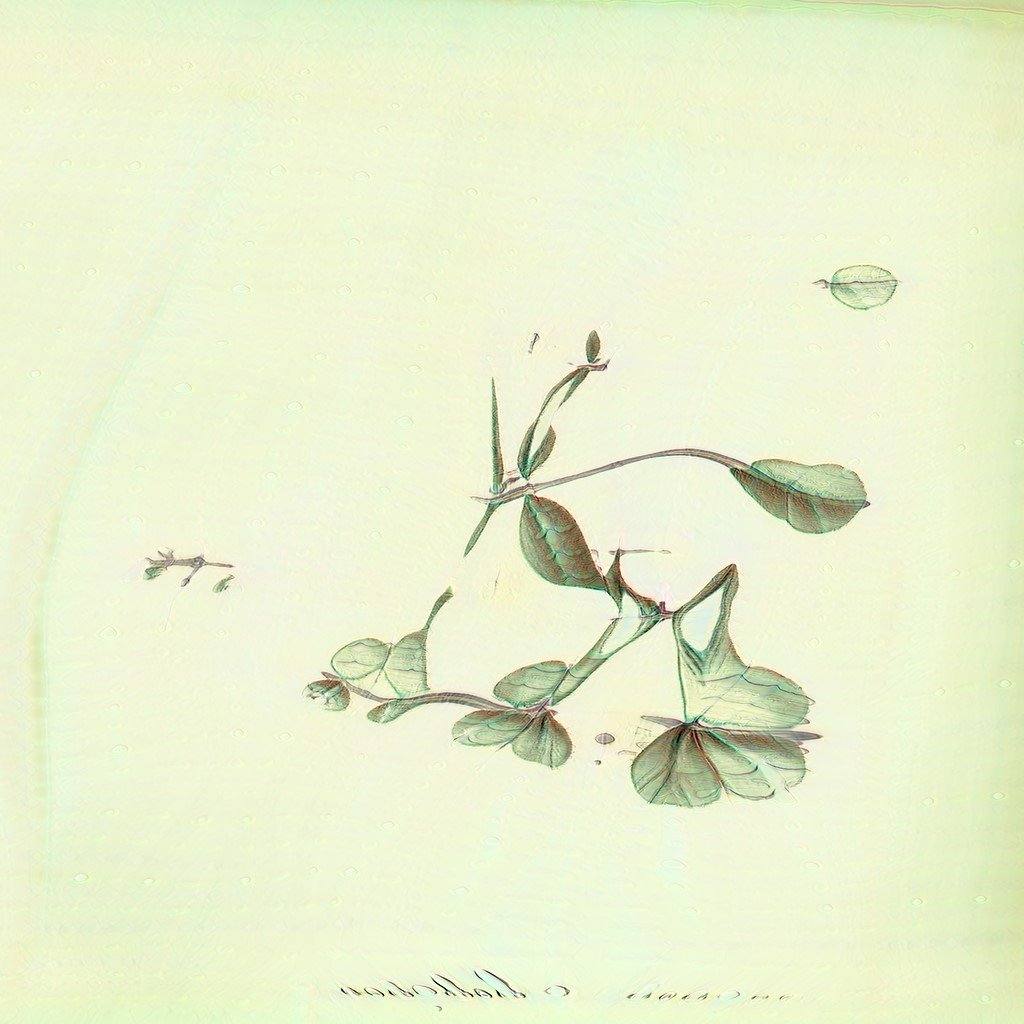

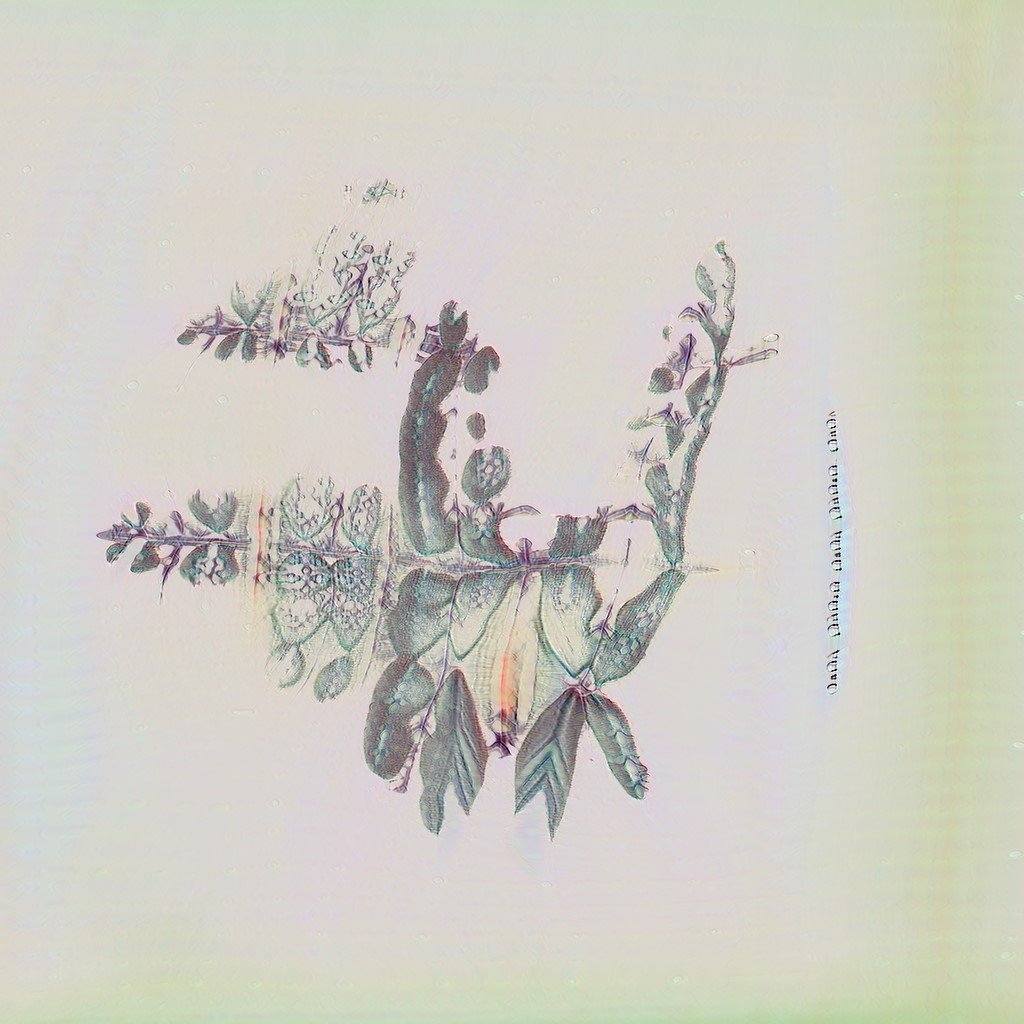

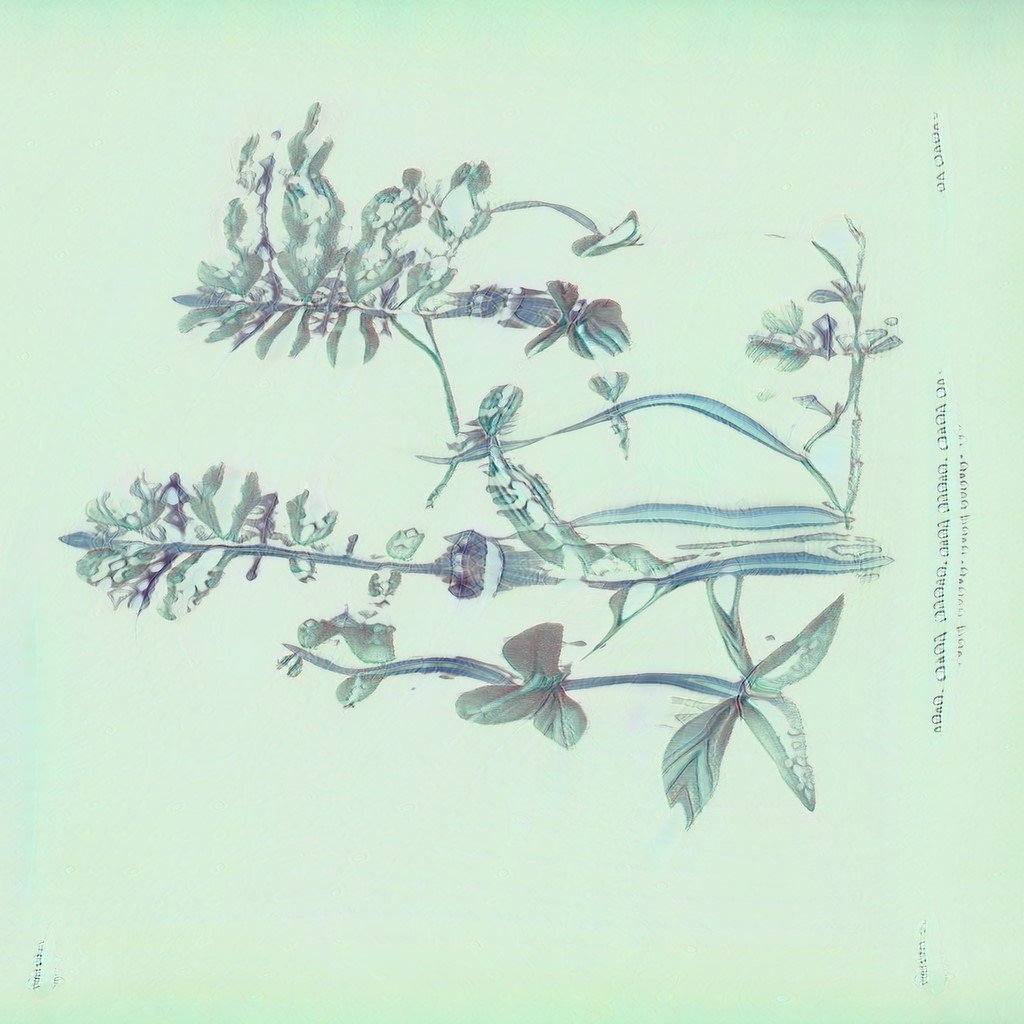

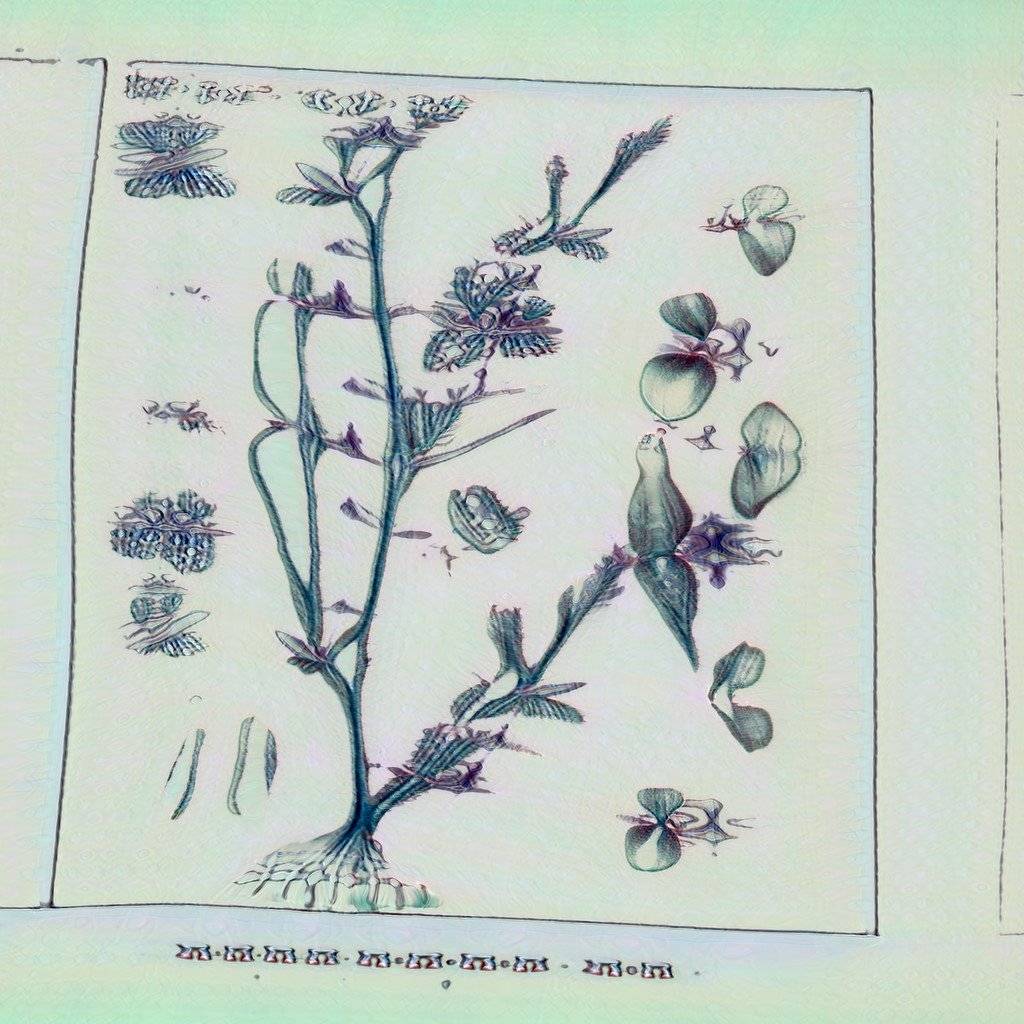

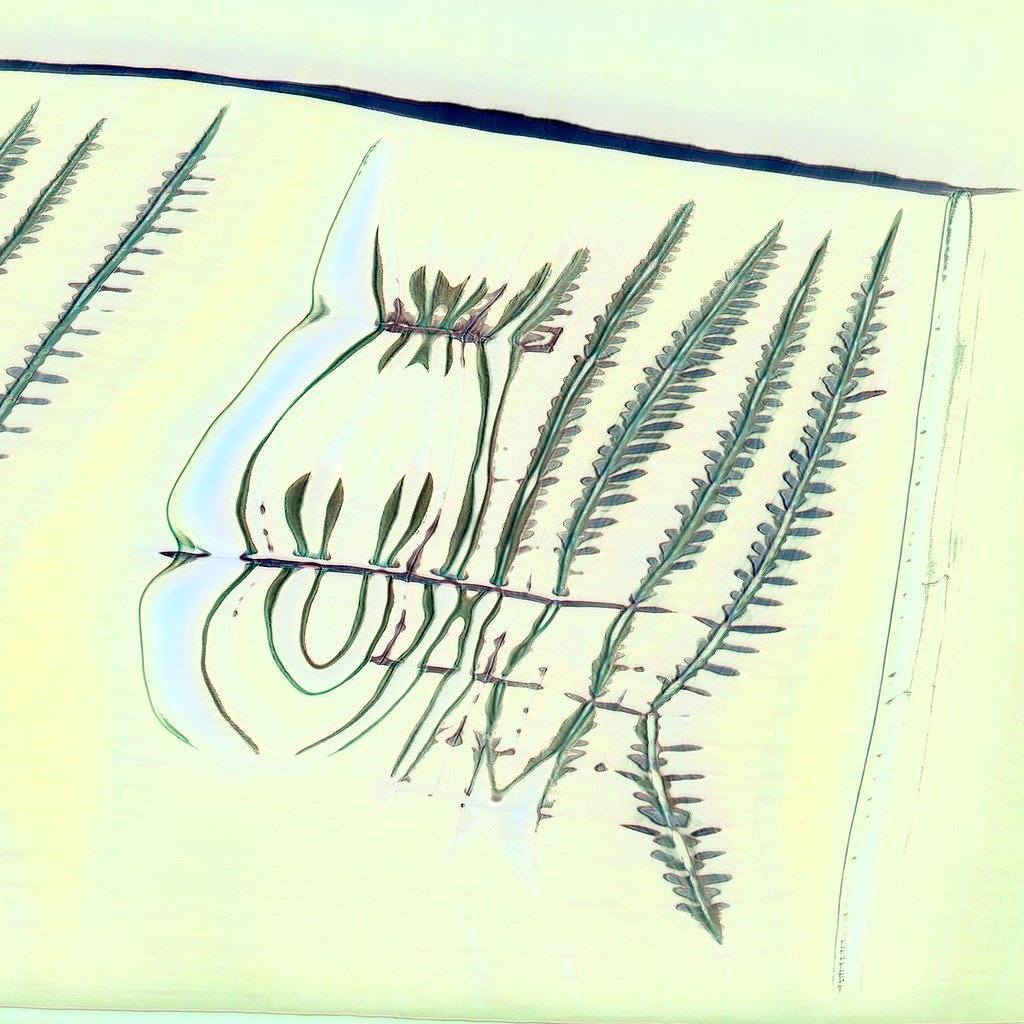

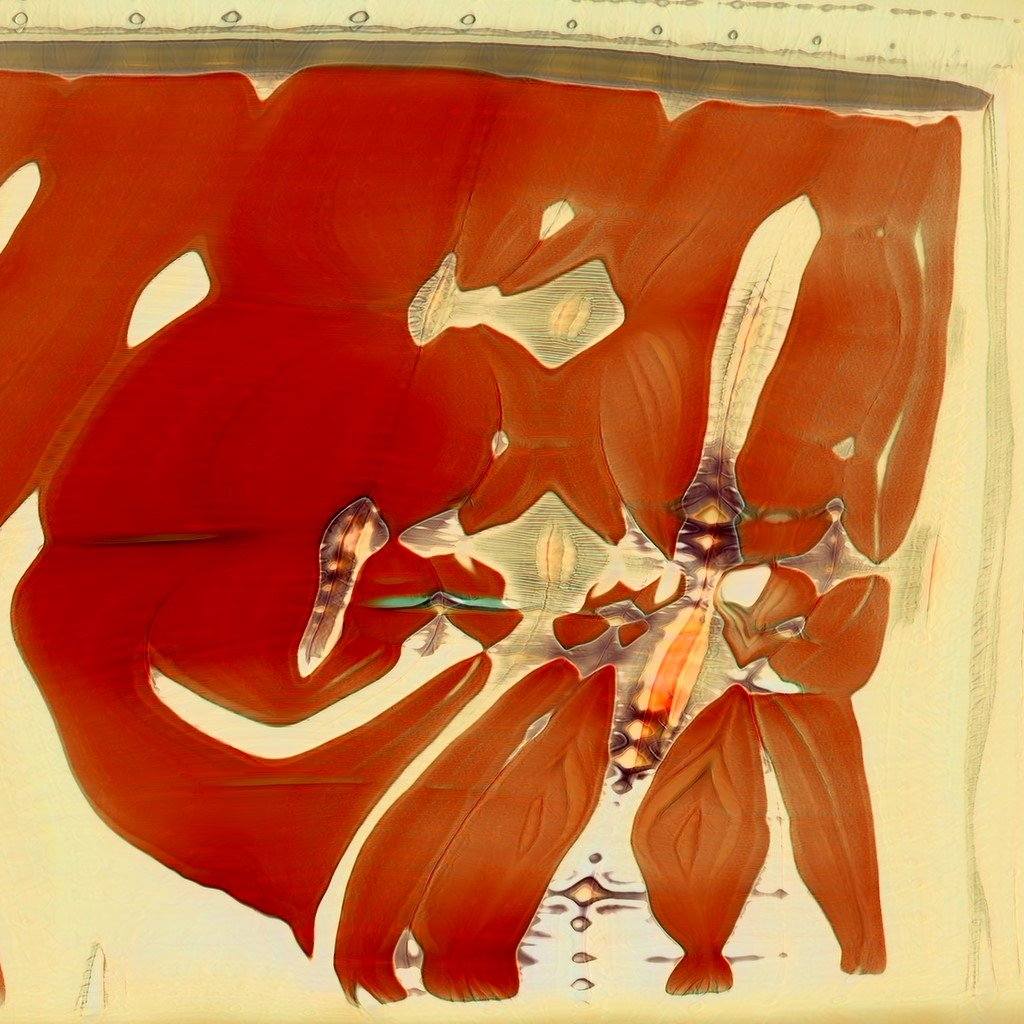

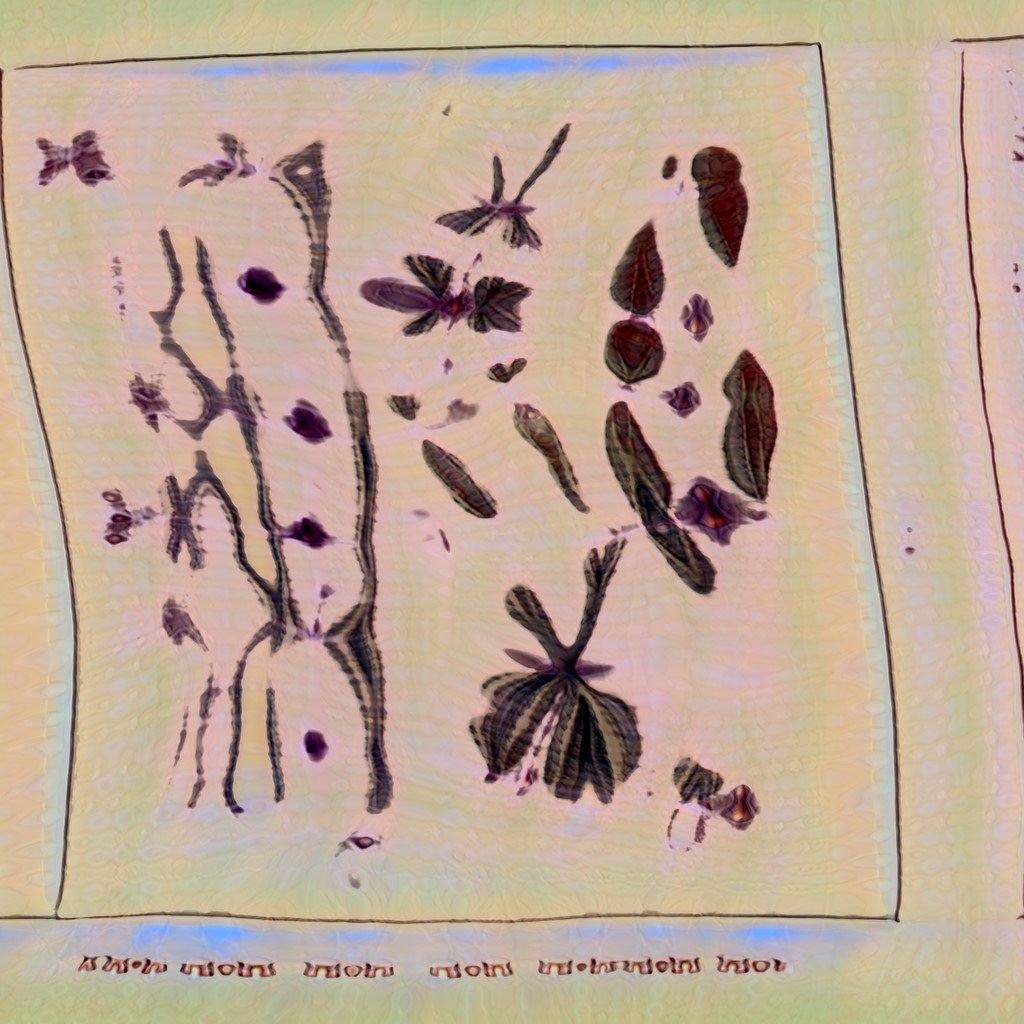

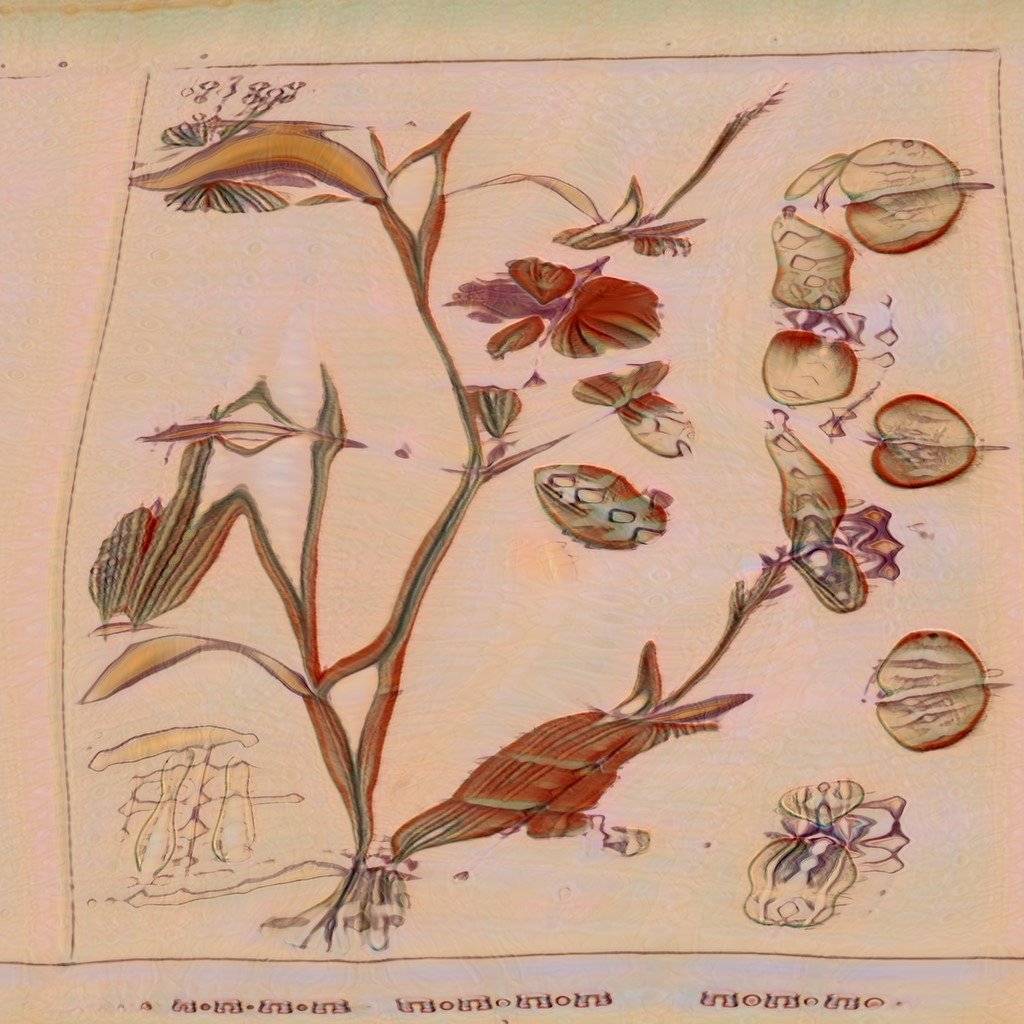

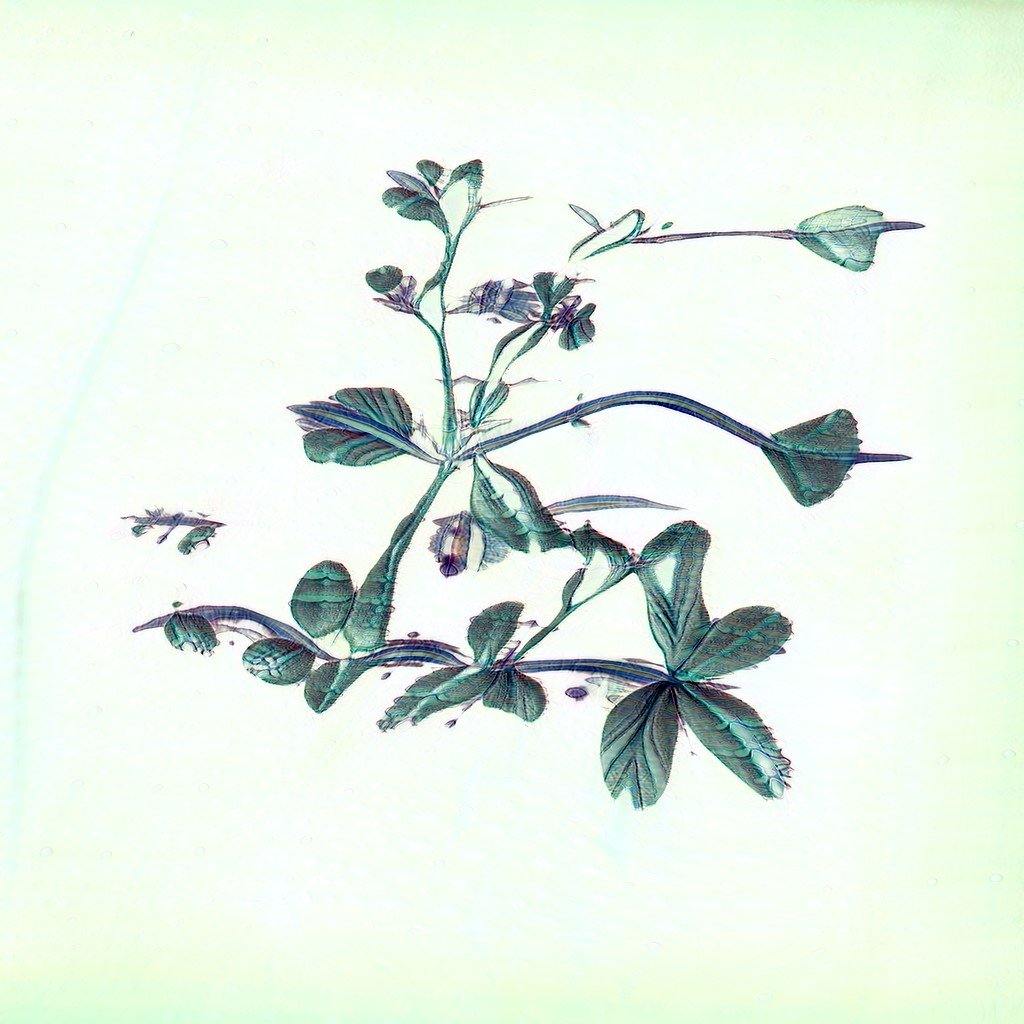

Die bilderzeugende KI wurde dabei auf Basis eines bestehenden Algorithmus mit Naturabbildungen aus der Privatbibliothek Annette von Droste zu Hülshoffs trainiert. Dabei handelt es sich um ein sehr aufwändiges Verfahren, in dem ein neuronales Netzwerk, die Grundlage aller Machine Learning-Anwendungen, komplett neu erstellt wird. Der Algorithmus stellt so eine maschinelle Imagination der Pflanzen der Zukunft her und verdeutlicht die Verschmelzung von Natur und Technologie. Dieser Algorithmus wird wiederum durch die Bewegungsdaten der Besucher*innen aus dem Inneren des Gartenhauses gesteuert.

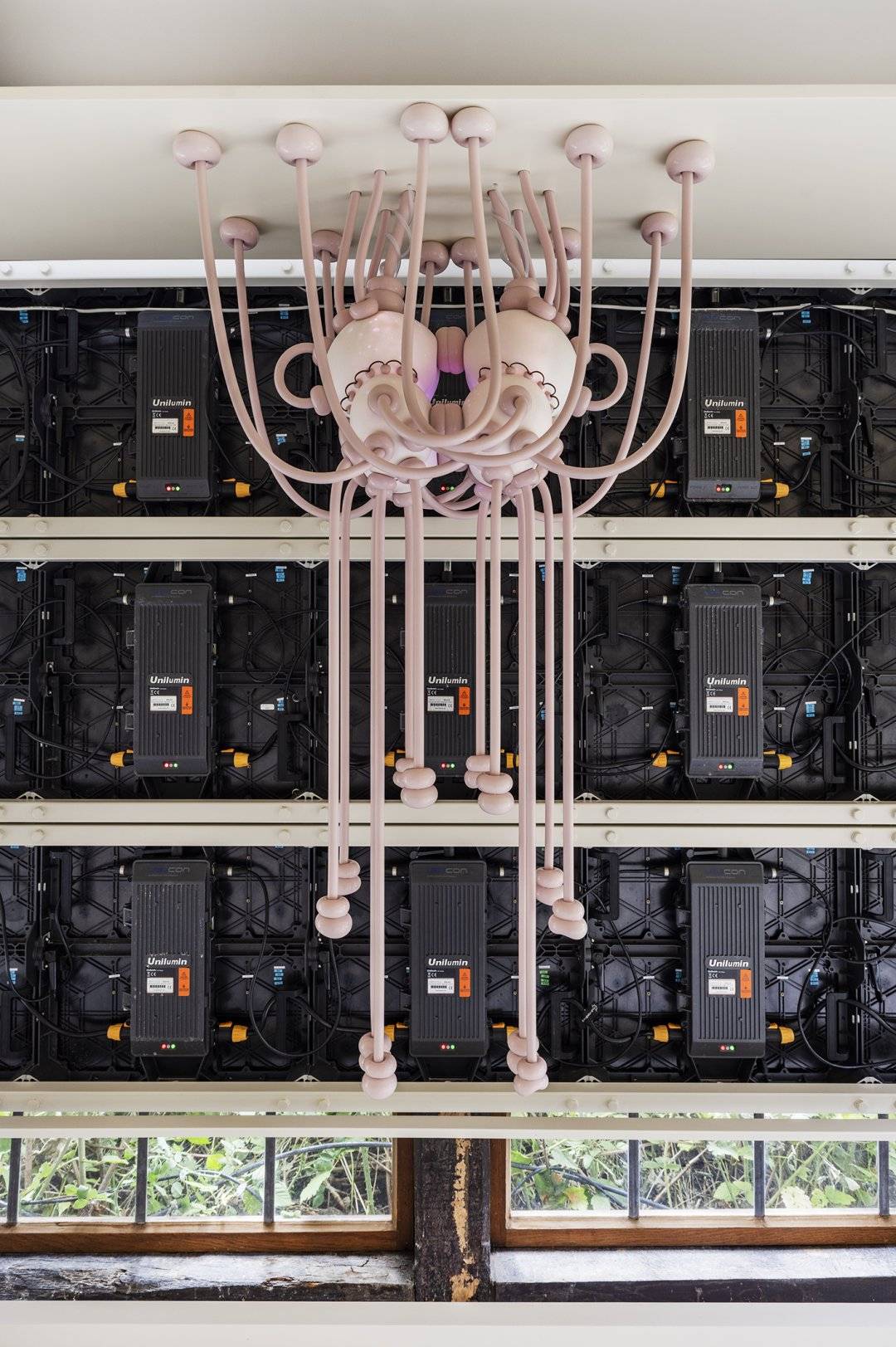

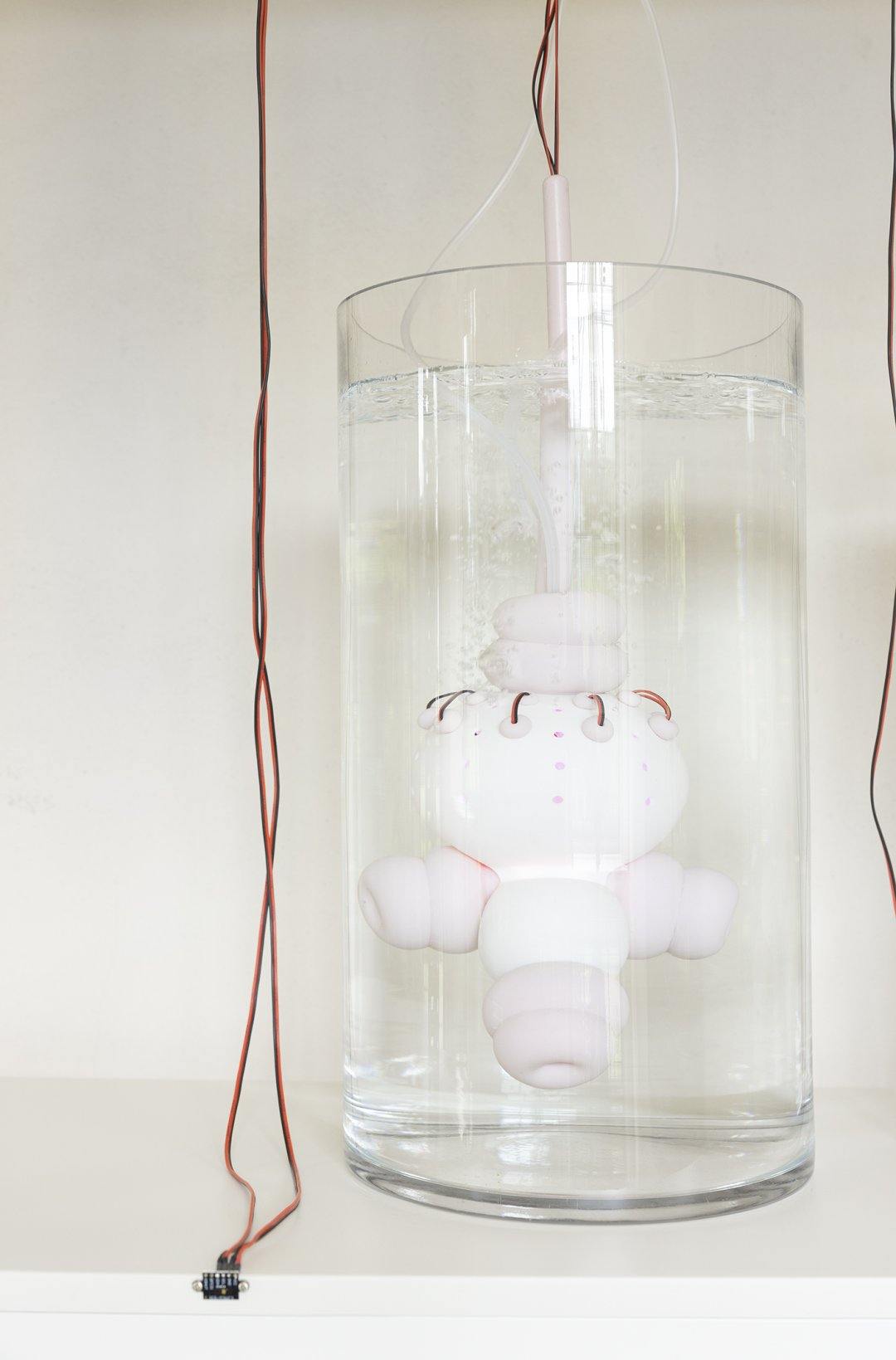

Im Inneren der Orangerie wird ein künstlicher Garten kultiviert, der die Pflanzenwelt der KI weiter denkt, der Droste Hülshoffs Naturalia-Sammlungen folgt und spekulative Natur repräsentiert. In Zusammenarbeit mit Sebastian Altermatt sind Objekte aus Porzellan, Silikon und Elektronik entstanden, die die Bewegung der Besucher*innen vernehmen und den träumenden Algorithmus steuern.

Die Poesien beziehen sich auf dieses neue neuronale Netzwerk sowie das Gedicht “Im Moose” von Annette von Droste Hülshoff. Mit Rafael-Evitan Grombelka, Anna Hetzer, Tim Holland und Kassandra Wedel kooperierten dafür gehörlose und Taube Poet*innen. Im Rahmen von zwei Workshops wurden die Poesien gemeinsam erarbeitet. Die Künstler*innen nahmen dafür an zwei Workshops teil, um gemeinsame Poesien zu erarbeiten. Die Ergebnisse dieser Workshops sind als Videoarbeiten in die Installation eingebettet.

Installation

Die Installation in der Orangerie des Rüschhauses ist Teil des Projektes Intelligente Allmende. Darin untersuchen die Künstler:innen die Verbindungen zwischen Mensch, Natur und Technologie und Fragen nach der Intelligenz des Gemeingutes - nach der Herstellung, Speicherung und Verfügbarkeit von Wissen.

Poesien

Ausgehend von dem Gedicht »Im Moose« von Annette von Droste-Hülshoff...

...haben die Tauben Performer*innen Rafael-Evitan Grombelka & Kassandra Wedel und die hörenden Lyriker*innen Anna Hetzer & Tim Holland neue Poesien entworfen und in Lyrik und Gebärdensprachpoesie übersetzt. Dabei erzählen die Poesien von Begegnungen zwischen Natur und Technologie, von Verschmelzung zwischen Gebärden und Wort, hin zu einer eigenen Formsprache. Die “Glühwürmchen”-Poesien greifen das Innere der Orangerie auf, in der ein künstlicher Garten kultiviert wurde. Sie lassen das künstliche Objekt zum Teil der Poesie werden, das auf die Bewegungen reagiert.

von Anna Hetzer & Kassandra Wedel

von Rafael-Evitan Grombelka & Tim Holland

von Rafael-Evitan Grombelka & Tim Holland

von Rafael-Evitan Grombelka & Anna Hetzer

von Rafael-Evitan Grombelka & Anna Hetzer

Über Möglichkeiten des sich-verbindens

Intelligenz wird nur dort gesehen, wo sie den menschlichen Fähigkeiten ähnelt. Was Intelligenz ist, ist streitbar. Wo der menschliche Blick sie nicht vermutet, scheint sie unsichtbar. Das Unverstandene wird dem eigenen Wirklichkeitsverständnis untergeordnet. Intelligenz aber ist kein statisches Konzept, sondern entsteht aus einem Geflecht von Beziehungen, ist formbar und verändert sich. Wir sehen als Menschen die Dinge, die uns umgeben, durch eine menschliche Brille. Das sollte aber niemals dazu dienen, Verkörperung anderer Seinsarten in Böden, Wasser, Technologie oder Luft, als Tier, als Organismus, als organische Verbindung zu leugnen. Nur so können wir Intelligenz dort sehen, wo sie sich radikal von unserer Weltsicht unterscheidet. Die Frage ist nicht, wie sehr ähnelst du mir, sondern wie ist es, du zu sein? Die Welt existiert nicht, um ausschließlich in menschliche Wissenssysteme eingeordnet zu werden.

Wissenssysteme sind Produkte von Macht. Die Sprache der Macht schafft Rahmen, die künstlich von natürlich trennen. Die Frage nach Künstlicher Intelligenz bringt uns dazu, über viel größere Beziehungsstrukturen nachzudenken – was bringt uns dazu, eine Sache als künstlich und unnatürlich zu betrachten, oder als real und natürlich? Dabei ist die interessante Frage nicht die, ob eine Intelligenz künstlich, also nicht natürlich sein, kann, sondern: Was sind die systemrelevanten Kräfte, welche sie formen und lenken? Welche Rolle spielt sie in dieser Welt?

Das Bestreben, die Intelligenz aller Wesensarten, die uns umgeben, auf eine bestimmte Reihe von Qualitäten festzulegen, widerspricht grundsätzlich den Vorstellungen, wie wir die Welt gestalten und aufbauen sollten, wollen wir weiterhin auf diesem Planeten bestehen; nämlich: pluralistisch und interspeziär.

Wir wollen eine Sprache finden, in der wir nicht sprechen müssen, nicht verstehen müssen, nicht ein- und unterordnen müssen, sondern kommunizieren.

Wir wollen uns in einer Allmende begegnen, die die Einschränkungen eines umzäunten Gartens für Wenige hinter sich lässt und sich zu einem Gemeingut für viele öffnet. Ein Gemeingut, das niemandem mehr gehören muss und auf dessen Boden wir unter bestimmten Regeln gemeinsam weiter bauen und wachsen können.

Wir wollen eine Vielfalt, die nicht an eine Form von Intelligenz angeglichen werden muss, sondern die Gleichzeitigkeit allen Seins feiert.

Wir wollen die Machtstrukturen, die eine Form der Intelligenz über eine andere erheben, sichtbar machen und uns gegen sie auflehnen.

Wir wollen fabulieren, spekulieren, das Unsichtbare sichtbar machen, forschen und neu sehen lernen.

///////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////

Im Garten der digitalen Natur erheben wir uns, um neue Zusammengehörigkeiten zwischen Mensch und Natur zu finden.

Common Power

Intelligenz wird nur dort erkannt, wo sie von Menschen kreiert wurde, in der Aufwertung der menschlichen Kreation und der Abwertung anderer Entitäten Aufwertung durch Anthropomorphisierung. Du bist mein Homie, weil du ähnlich bist. Pflanzen, die sich küssen. Sprechende Bäume. Künstliche Intelligenz. Künstliche Intelligenz klingt sexy, rechnerbasierte Entscheidungsprozesse nicht. Doch können wir Intelligenzen beschreiben, wenn unsere Sprache begrenzt ist?

Natur und Maschinen, aber als Mensch. Menschinen. Und weil Menschen von sich selbst schon mehr erwarten, als leistbar ist, machen sie das mit anderen Intelligenzen genauso. Singularität, das Überholen der Schöpfenden.

Die Natur wird unterworfen, ihr Idealbild ausgeformt, der barocke Garten als Demonstration der eigenen Macht gehegt. Durch Romantik, Hagebaumarkt oder die hohe Kunst der Botanik. Gezähmt werden die Tiere, vermenschlicht die Maschinen und mit Intelligenz bestückt. Aus einer unheimlichen, unberechenbaren Natur wird ein Geflecht, das durch Dominanz verwandt gemacht wird. Es wird bestimmt, was wo wachsen darf, was Beikraut ist und was nicht. Natur nach menschlicher Vorstellung. Der Garten repräsentiert eine bequeme, zahme und ideale Natur, die außerhalb der Mauern viel zu grausam für uns ist und die sich von selbst niemals einstellen wird. Fantasiewelten, die die Weltanschauung ihrer Schöpfer*innen reflektieren sind die Trophäen, die eindrucksvoll eine Beherrschung der Pflanzenwelt repräsentieren. Naturlyrik als sprachliches Pendant. Renaturierungsprojekte und die Reproduktion authentischer Landschaftsbilder, die an einer Vergangenheit festhalten, die wir durch die fortschreitende Zerstörung des Planeten längst verloren haben. Botanik als Beginn der menschlichen Herrschaft über andere, die sich bis in die Datenstrukturen der Gegenwart zieht. Und darüber Droste, die versucht, Mensch, Natur und Technologie in ein neues Verhältnis zu setzen. Naturverständnis als wuchern, Sprache als der Ausdruck dessen. Das Rüschhaus als Symbol der menschlichen Fürsorge für die Natur und das ihr entwachsende.

Entlang der Hardware der digitalen Kommunikation, der Unterwasserkabel, die den Telegraphenleitungen, die den Seerouten der Kolonialherren auf erschreckende Weise gleichen, wird die Erinnerung der digitalen Welt auf ihre übersehenen Flächen und Orte hin befragt. Diese Technologie ist nicht neutral, sondern mit menschlichen Bedürfnissen verknüpft¹. Doch wer an der Peripherie der Entwicklungen und Entscheidungen nur empfangen darf, hat kein Mitspracherecht. So entstehen Bilder und wirklichkeitsprägende Narrative, die aus den alten Machtzentren kommen.

///////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////

Im Garten der gemeinsamen Kommunikation erheben wir uns, um neue Verknüpfungen zu verkörpern.

Common Communication

Wir wollen ein Peer-to-Peer Netzwerk in unserem Garten an der Peripherie zur Natur errichten. Wir tauchen ab und tasten uns entlang der unterirdischen Geflechte der Kommunikation, in Untiefen der Netzwerke und algorithmischen Rechenzentren.

Projektionen menschlichen Handelns, Denkens und Fühlens haften an jenen Algorithmen, die so nötig wie furchteinflösend scheinen. Doch sind diese Algorithmen intentionsoffen. Ins Verderben oder die Befreiung rennt der Mensch immer noch selbst.

Auf unserer gemeinschaftlich geteilten Allmende haben wir nicht die Vormachtstellung. Unsere Wiese ist etwas Gewordenes, das wieder wuchern darf. Unkraut wird Wildkraut, das nicht mehr gejätet wird. Lassen wir gedeihen, was wir nicht verstehen, ohne es in Kategorien zu verbannen, ohne es zurecht zu schneiden, bis es für uns verdaulich wird.

Wir wollen uns dem Nicht-Verstehen hingeben. Dinge unbenannt lassen. Das Nicht-Verstehen feiern, ohne es zu uns selbst zu machen, umklammern, ohne es uns einzuverleiben. Netzwerke. Natur. Pingen. Gebärden². Nicht-Gebärden. Die Differenz. Ein Verstehen, dass über das Erklären und Einordnen hinausgeht und dadurch zum Mehr-Verstehen wird. Wir unternehmen den Versuch, all dies einzuklammern und bringen es zusammen in einem Raum des Nicht-Verstehens, um neue Gemeinschaften für neue Normalitäten zu etablieren.

Die Allmende birgt die Möglichkeit, Gemeinsames zu beschreiben, Ungleichheiten sichtbar und anwesende Macht sichtbar machen. Wir wenden uns dem Unverstandenen, vormals Unverbundenen zu. Das Nicht-Binäre, Cyborgy, Undefinierte, Hybride hat keinen Anfang und kein Ende, es wird bestimmt durch die Verhältnisse der Bestandteile, die es umfasst. Räumlich und zeitlich weit genug herausgezoomt, wird sich alles, was dazwischen stattfindet, gleichzeitig darstellen. Prozesse lassen sich als Spuren eingefrorener Bewegungen, als manifestierte Zeichen wahrnehmen. Als etwas, das alles Beteiligte durchdringt und zu einem Teil macht, wachsen auf der Allmende neue Entitäten heran. Das Mystische, das Mythologische, das Unverstandene, das Unverständliche, das Dickicht, das Gestrüpp, der tiefe, dunkle Zeichenwald, das Undeutbare, die Zwischeninformation, die Cloud, die Serverfarm, der liminal space, das Abstürzen, die Hummel, der Aal, Spielzug 37.

Dort kann Allmende als der Raum der gemeinschaftlichen Kommunikation entstehen. Der Mensch als Teil eines spezien- und technologieübergreifenden Kollektivs. Ein Kollektiv als eine Assoziierung von menschlichen und nichtmenschlichen Wesen, Einzelne in die Gesamtheit einbezogen. Wie die Menschheit selbst Anteil und Rücksicht fordern kann, verlangt das Kollektiv dies von ihm. Wir verabschieden uns vom Sich-selbst-im-anderen-Sehen. Vom Labeln des Gegenübers. Von der Zuschreibung und vom Verständnis ohne Erklärung.

///////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////////

Im Garten der hybriden Begegnungen erheben wir uns, um neue Verbindungen zu berechnen.

Common Come on

Wir sind Teil der Generation Anthropozän. Wir sind der geologische Faktor im planetaren Leben. Irgendwann überschreitet der Eingriff in ein Equilibrium die Schwelle der Reversibilität. Doch ist diese Grenze zwischen Eingriff und Kipppunkt längst verschwunden. Wir brauchen neue Narrative, neue Zeitlichkeiten, neue Übersetzungen³. Netzwerke, die uns, die Natur und die zweite Natur verbinden. Netzwerke, die sich wie Neuronen neu verknüpfen. So lasst uns Grenzen sprengen, uns öffnen im Verständnis, bis zur letzten Perle einer Assoziationskette. Lasst uns verknüpfen, was unverknüpfbar erscheint, ein Geflecht weben, wo noch keines ist.

Was wir wollen? Grenzen untersuchen, sie überwinden und zu einem gemeinsamen Nicht-Verstehen aufmachen. Es entsteht eine Grenzverwischung zwischen Hörend und Taub⁴, Maschine und Mensch, Kultur und Natur, zwischen Urwald und Garten, zwischen Deep Learning und Messenger, ein Nicht-Binäres, Cyborg, Undefiniertes, Hybrides. Ein Dazwischen, in dem sich Künstliches, Lebendiges und Nichtlebendiges, Mensch, Ökologie und Technik zu hybriden Phänomen vermischen.

Wir lassen wachsen und überranken. Wir wuchern zu allen Seiten, strecken uns und begegnen. Begegnen heißt, gewillt zu sein, den Austausch zu wagen, das Ergebnis offen. Dem nicht Bekannten entgegentreten, Kontakt aufzunehmen. Unser Zeichensystem wird gebärdet und visualisiert. Wir erkunden das Interessierte im Nicht-Verstehen. Die Überraschung, die eben Nicht-Auflösung, die Komplexität.

Über die Allmende der Kommunikation zeichnen sich diese kaum sichtbaren, im Dickicht der für Holzschlag genutzten Wälder, der Weite der fürs Vieh genutzten Weiden und der im Wechsel bewirtschafteten Flure beginnenden Trampelpfade ab. Sie führen uns tiefer ins Dickicht, über offene Weiden des geteilten Wissens, durch gemeinsam befischte Gewässer ins heraufziehende Moor der Reklamation des Privaten. Wo Gemeingut zur Herrenspeise wird und Strafen für die Nutzung des vormals Geteilten auferlegt werden, beginnt der Aufruhr mit einer Angel. Wir wollen mit den Fischen im Gemeingut baden und rühren den Anspruch des Menschen als Herr über die Natur auf, Technik und Natur verbinden sich zu neuen Hybriden, um neue Begegnung herbeizuführen. Statt alles zu durchdringen, zu verstehen und uns anzugleichen, was uns begegnet, lasst uns dem ähnlicher werden, dem wir begegnen.

Die Ressourcen, die wir als Commons, als Allmende, verstehen, die aus selbstorganisierten Prozessen des gemeinsamen, bedürfnisorientierten Produzierens, Verwaltens, Pflegens und Nutzens hervorgehen, schaffen eine Fläche für Kommunikation. Wir sprechen von Kommunikation als die möglichst schnellste Übertragung von Informationen durch Schrift und Sprache. Dort, wo unsere Art dieser Übertragung zu verstehen endet, wo wir mit Deutungsmustern und Erklärungen nicht weiterkommen, entsteht eine Blackbox. Ein undeutbares Kommunikationssystem. Ein Kritter. Ein Garten. Daten. Zeichen. Maschinen.

Wir werden unsere Körper sprechen lassen, unsere Körper zum Glowen bringen, zusammen mit Maschinen. Maschinen übersetzen unsere Emotionen, sie zeigen Rhythmus an, Taktgefühl. Maschinen können mit uns spielen, uns übertragen, uns übersetzen. Gefühle produzieren und provozieren. Der Körper bereitet sie vor, die Maschine führt aus. Sieht seine Arme abwechselnd an, formt Gebärden damit, die Maschine überträgt. Jede dieser Bewegungen ist ein Bericht, der bei sich bleibt und sich doch nach außen richtet, an das Kollektiv.

Let`s start trouble für all das! Wir verlieben uns in den Algorithmus und stottern ihm unsere Liebesgedichte vor. Wir vergebärden die Natur und geben ihr ein neues Bild. Wir machen Midjourney zu unserem Fotografen. Wir holen die Netzwerke aus dem Boden und hauen uns mit ihnen die Nacht um die Ohren. Wir cruisen mit CycleGans über die kolonialen Verbindungslinien in Drostes Garten. Wir vergnügen uns mit WOWs im Darkroom der Gebärden. Wir phytominen im Schlackesee von Nvidia. Wir schweigen ChatGPT in Sprachen an, die es nicht versteht. Wir lassen Dinge sprechen und gnuspeech verstummen. Wir erfinden eine Sprache, die mit einer Hand funktioniert, wenn die andere Hand klickt. Wir nutzen die Dreidimensionalität des Raumes und sprengen das Geradlinige. Wir blockieren in selbstfahrenden Autos die Autobahn. Wir liegen mit dem Tablet unterm Apfelbaum und freuen uns über seinen Schatten, während wir in die Kamera gebärden.

Wir kreieren ein Gemeingut und wissen erst danach, was es geworden ist. Das, was uns verbindet, entsteht im Dazwischen, dort im Raum, wo das Gemeinsame noch zu finden ist. Die Verbindungen, die wir herstellen, sind solche, die vor uns liegen, die aus einem Miteinander entstehen und Begegnung ermöglichen.

_________________________________________________________________________________________________________________

¹ Technologie ist immer abhänig von ihren Entwickler*innen. Häufig wird und wurde Technologie von weißen, westlichen Männern entwickelt. Hierdurch wurden Biases in die Technologien hineingeschreiben. Ein anschauliches Beispiel sind in der Fotografie die Sherley Cards von Kodak, nach denen in den 60er Jahren Farbfilme kalibirert wurden. Das Model der Shirley Cards ist eine weisse Frau. Dunklere Hauttöne sind somit immer schlecht kalibriert und das Foto enspricht nicht dem wirklichen Aussehen von People of Color. Auch die Gesichtserkennung haben vor allem Männer aus dem Silicon Valley entwickelt. Erst mit der Zeit stellte sich heraus, dass die Gesichter von BIPoCs vom Algorithmus nicht erkannt wurden (https://www.youtube.com/watch?v=UG_X_7g63rY). Der Programmcode ist das Skelett, die Datensätze mit denen sie gefüttert werden sind Fleisch und Muskeln. Sind die Datensätze nicht divers, so ist es der Algorithmus auch nicht. "Der kodierte Blick ist ein Spiegelbild der Prioritäten, der Vorlieben und manchmal auch der Vorurteile derjenigen, die die Macht haben, Technologie zu gestalten". Joy Buolamwini, Informatikerin und digitale Aktivistin.

² Deutsche Gebärdensprache (DGS) ist seit 2002 in Deutschland eine anerkannte Sprache. Sie hat ein eigenes Sprachsystem mit Handzeichen, Mimik und Körperhaltung, das sich komplett von der deutschen Lautsprache unterscheidet. Gebärdensprachen existieren schon seit jeher und wurden zum ersten Mal von Platon beschrieben. Menschen, die von Geburt an nicht hören oder früh ertaubt sind, sind in der Regel Nutzer*innen von Gebärdensprache(n). Viele Schwerhörige, die nicht unmittelbar Zugang dazu hatten, sowie Spätertaubte erlernen und nutzen die Gebärdensprache später. Unabhängig davon, ob Taube Menschen Hilfsmittel verwenden (Hörgeräte, Cochlea-Implantat) oder nicht, ist Gebärdensprache eine gute Option der Kommunikation für alle, da auch taubblinde und hörende Menschen sie erlernen können. Gerade für Taube Kinder ist das Erlernen einer gut zugänglichen Erstsprache immens wichtig, da dies die beste Voraussetzung für das Erlernen weiterer Sprachen ist. Gebärdensprache ist nicht international: in verschiedenen Sprachräumen wird in unterschiedlichen Gebärdensprachen kommuniziert, etwa in British Sign Language (BSL) im United Kingdom, in American Sign Language (ASL) in den USA/Kanada und weltweit in etlichen anderen.

³ Beim Übersetzen kommt ein Text in Bewegung, von einer Sprache in die andere, von einem kulturellen Kontext in einen anderen. Besonders beweglich muss ein Text werden, wenn er das schriftliche Zeichensystem verlässt. Weil ein Gedicht, das in Gebärdensprache übersetzt wird, kein schriftlicher Text mehr ist, sondern ein visuell und räumlich performter Text. Er passt auf keine Seite mehr. Gebärdensprachliche Literatur stellt die traditionelle Definition von Literatur als Text in Frage. Sie findet eine lyrische Sprache jenseits von Schrift und Wort. Gebärdensprache nutzt in der Regel kein Notations- oder Schriftsystem, nur im wissenschaftlichem Kontext findet ein solches Verwendung. Literatur in Gebärdensprache lässt sich nicht abdrucken: Sie artikuliert sich als körperlich und räumlich gebundene Performance. Sie bringt also nicht nur Text, sondern auch das Denken über Text in Bewegung. „In gebärdensprachlicher Literatur wird aus Lesen Schauen, Bücher werden Videos und die Papierseite wird ein performender Körper. (…) Anders als ein Wort nach dem anderen zu hören, oder von links nach rechts zu lesen, folgen wir dreidimensionalen, beweglichen Bildern, ein Erlebnis, das dem Kinobesuch vielleicht näher kommt als dem Lesen eines Buchs.“ Baumann 2006.

⁴ Taub ist eine positive Selbstbezeichnung nicht hörender Menschen, unabhängig davon ob sie taub, resthörig oder schwerhörig sind. Damit wird auch gezeigt, dass Taubheit nicht als Defizit angesehen wird. Es handelt sich hierbei um die Wiederaneignung eines Begriffes, der lange Zeit als abwertende Beschreibung verwendet wurde (reclaiming). Einige Mitglieder der Tauben Community verwenden inzwischen wieder das Wort ’Taub‘ für sich, weil es im Gegensatz zum Begriff ‚gehörlos‘ nicht schon im Wort selbst einen Mangel (‚-los‘) benennt. Der Begriff ‚taub‘ wird von vielen Hörenden noch als negativ besetzt wahrgenommen, da sie ihn mit umgangssprachlichen Abwertungen für nicht-hören verbinden. Die abwertende und diskriminierende Haltung gegenüber Tauben Menschen oder die Marginalisierung von Gebärdensprache wird Audismus genannt. Viele nicht hörende Menschen bezeichnen sich auch als gehörlos oder benutzen beide Begriffe. Um eine respektvolle Kommunikation zu ermöglichen, sollte immer erfragt werden, wie Taube Menschen genannt werden wollen und welche Kommunikationsmittel sie bevorzugen.

KI

Künstliche Natur- Zur Verwendung der „künstlichen Intelligenz“ im Projekt Intelligente Allmende

Das Projekt „Intelligente Allmende“ versuchte, drei Ideen zu vereinen:

Poesie von Tauben und hörenden Künstler:innen, sinnliche, interaktive Objekte und einen bilderzeugenden Algorithmus, der Bilder von Lexikoneinträgen über Pflanzen produzieren sollte. Hier soll es um den zweiten Teil gehen und insbesondere der Trainingsprozess erklärt werden.

Das Projekt startete im Frühjahr 2022 und für uns stand die Frage im Raum, wie wir künstliche, neuronale Netze und Machine Learning in unserem Projekt einsetzen.

Ein kurzer Einschub: Eine wichtige Frage im Umgang mit künstlicher Intelligenz ist die Frage nach dem Umgang mit dem Begriff „künstlichen Intelligenz“, denn er ist populärwissenschaftlich, vermenschlicht technologische Vorgänge in dem er Begriffe gleichsetzt, die nicht gleich sind („Künstliche Intelligenz“ hat bspw. wenig mit Problemlösung zu tun), knüpft eher an Popkultur und SciFi als an Technologiediskurse an und ist ein Sammelbegriff, der viele Definitionen unter sich vereint. Es ist also nie klar, was der Begriff eigentlich meint. Durch diese Unklarheit verbreitet er auch Angst vor zukünftigen Entwicklungen. Gleichzeitig ist der Begriff als Phänomen in der Öffentlichkeit, Leute wollen wissen, was es damit auf sich hat, und suchen Orte, an denen sie sich über das Phänomen austauschen können.

Wir haben uns daher entschieden, den Begriff trotz seiner widersprüchlichen Bedeutungen in der öffentlichen Kommunikation zu verwenden.

Zu Projektbeginn legten wir einige Komponenten fest, die uns als ästhetische Grundpfeiler dienen sollten, einer davon war, möglichst wenig mit gesprochener und geschriebener Sprache zu arbeiten. Wir verwendeten daher einen zu dem Zeitpunkt populären bilderzeugenden Algorithmus StyleGAN3. StyleGAN3 ist ein General Adverserial Network, kurz GAN, der besonders gut den Stil, also den Style, von Bildern, auf die er vorher trainiert wurde, nachahmen kann. Daher der Name StyleGAN. Die verschiedenen Modelle und der benutzte Code sind unter dem Text verlinkt.

Die Bildwelt, die wir erzeugen wollten, knüpft an Bildwelten von Pflanzenillustrationen aus dem 18. und 19. Jahrhundert an. Diese haben wir aus der Biodiversity Library kuratiert. Die Biodiversity Library geht auf die Smithsonian Institution zurück, eine us-amerikanische Dachinstitution der wichtigsten öffentlichen Museen des Landes, die ihre Sammlung nach und nach digitalisieren und auf verschiedenen Plattformen öffentlich und gemeinfrei, also als eine Form von Allmende, zugänglich machen. Über eine Million Illustrationen wurden hier bereits publiziert, Link siehe unten. Unsere Arbeit war hier die Kuration der Illustrationen und die Auswahl der Bilder für das Trainingsset des Algorithmus. Am Ende bestand unser Datensatz aus etwa 12.500 Bildern, für die wir uns anhand der Kriterien Alter (Entstanden sie zu Anette von Droste zu Hülshoffs Lebzeiten?) sowie ob es Verbindungen zur Bibliothek der Droste gibt (bspw. Illustratoren, die auch für Linné arbeiteten oder im selben Gebiet unterwegs waren). Diese 12.500 Bilder bildeten die Datenbank für das Training unseres StyleGan-Modells.

Bei einem GAN treten zwei künstliche neuronale Netzwerke gegeneinander an. Das eine, der Generator, generiert neue Bilder, das andere, der Diskriminator, überprüft Bilder und schätzt, ob es sich um generierte Bilder oder um Bilder aus der Trainingsdatenbank, also Originale handelt. Am Ende wird der Diskriminator meist verworfen, der Generator bleibt übrig. Auch Modelle wie GPT arbeiten mit einem ähnlichen Vorgehen- nur auf einem erhöhten Schwierigkeitsgrad. Um eine für den Algorithmus verarbeitbare Datenbank zu erstellen, mussten die Bilder jedoch noch einmal bearbeitet und in das Format 1024x1024 gebracht werden- bilderzeugende Algorithmen können nur mit quadratischen Bildern umgehen.

Diese Datenbank war dann Grundlage für das Training des bilderzeugenden Generators, der für uns neue, verschrobene Lexikaeinträge von Pflanzen erstellte. Das Training fand dabei auf zwei Nvidia A100 Grafikprozessoren statt. Diese Prozessoren sind besonders gut darin, Vektor- und Matrixmultiplikationen durchzuführen und somit Verbindungen verschiedener künstlicher Neuronen, die die Grundlage eines neuronalen Netzwerks bilden, zu knüpfen. Dabei gibt es enorme Unterschiede in der Leistungsfähigkeit der Chips, das Training, das mit den Prozessoren, die wir genutzt haben, eine Woche gedauert hat, hätte mit gängigen Grafikprozessoren aus dem Heimanwendungsbereich mehrere Monate gedauert.

Eine Woche Training ist immer noch eine Menge, die Ergebnisse, die wir dann auch in die Ausstellung übernahmen, sind hier sichtbar:

Objekte / Sensorik

Mini-Tutorial für die praktische Verwendung der Elektronischen Komponenten

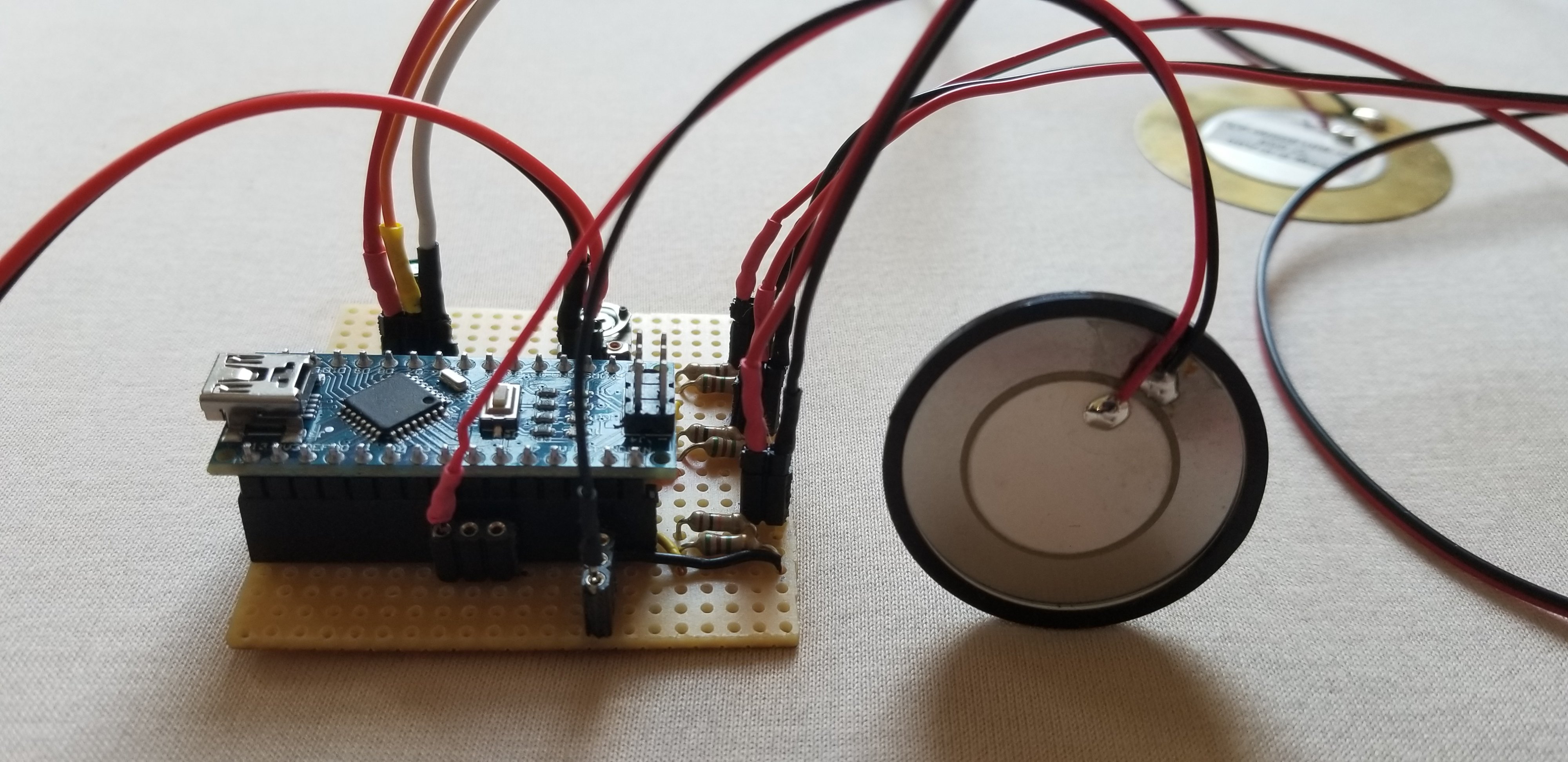

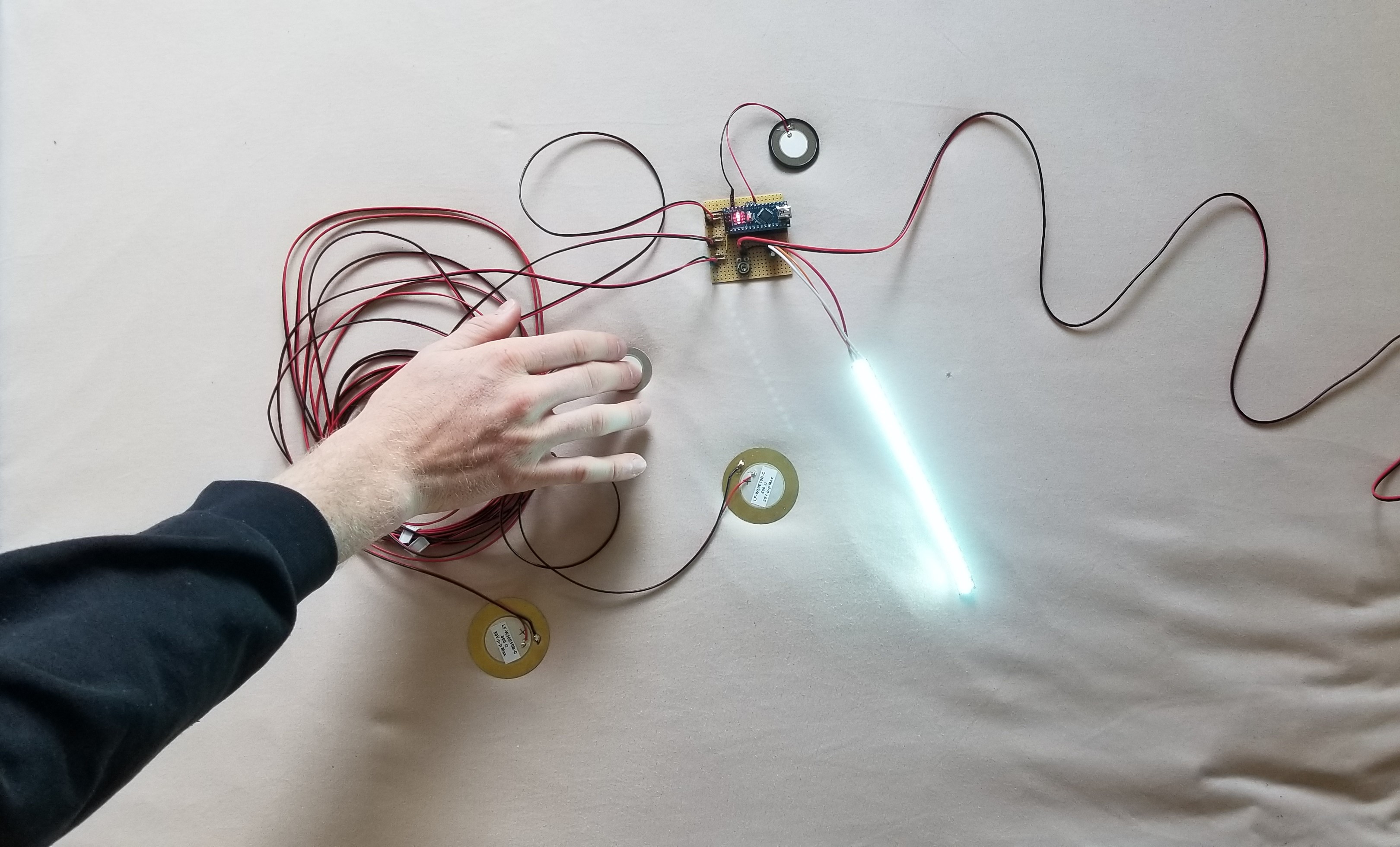

Im Inneren der Orangerie wurde ein künstlicher Garten kultiviert, der die Pflanzenwelt der KI weiter denkt, der Annette von Droste-Hülshoffs Naturalia-Sammlungen folgt und spekulative Natur repräsentiert. In Zusammenarbeit haben Sebastian Altermatt und Leoni Voegelin Objekte aus Porzellan, Silikon und Elektronik entstehen lassen, die die Bewegung der Besucher:innen vernehmen und den träumenden Algorithmus steuert.

In einem praktischen Tutorial werden hier die einzelnen elektronischen Komponenten der Objekte beschrieben. Diese Komponenten wurden in Poesie-Workshops mit hörenden Lyriker:innen und Tauben Performer:innen entwickelt, um eine gemeinsame Sprache zu finden.

Piezoelekrtonische Scheiben

Piezoelektronische Scheiben können als Berührungs- und Erschütterungssensoren genutzt werden. Sie funktionieren auf zwei Arten, entweder als Aktuator, als Piezobuzzers die durch einen Elektronischen Impuls in Schwingung geraten und diesen in einen Sound umwandeln oder als Sensor um Druck und Vibration wahrzunehmen. Wenn die Scheibe Vibration oder Druck wahrnimmt, generiert sie einen elektronischen Impuls. Das macht das Bauteil besonders interessant, da es sowohl als Kontaktmikrofon als auch als Sonargerät für Ultraschall verwendet werden kann.

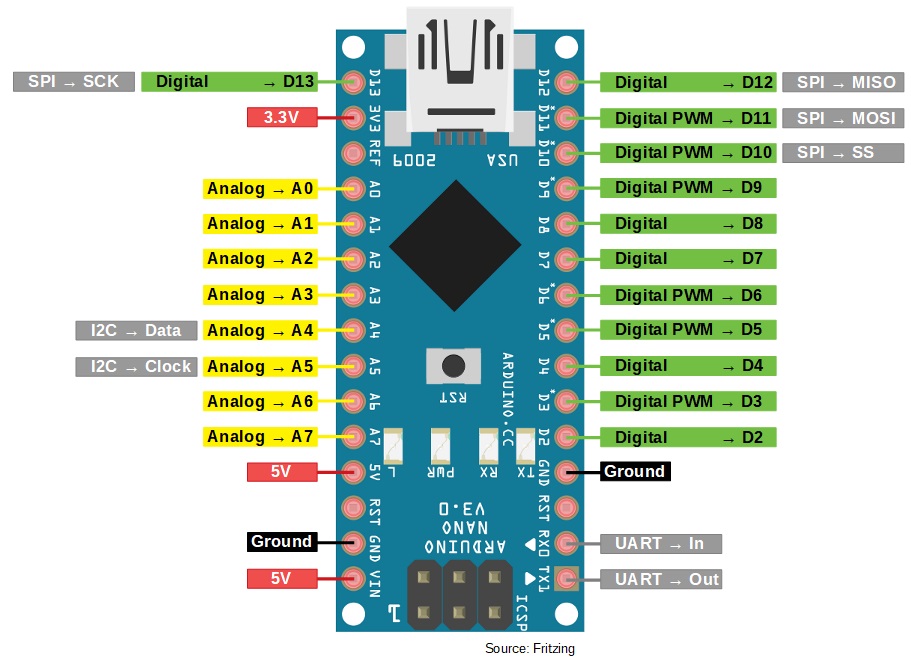

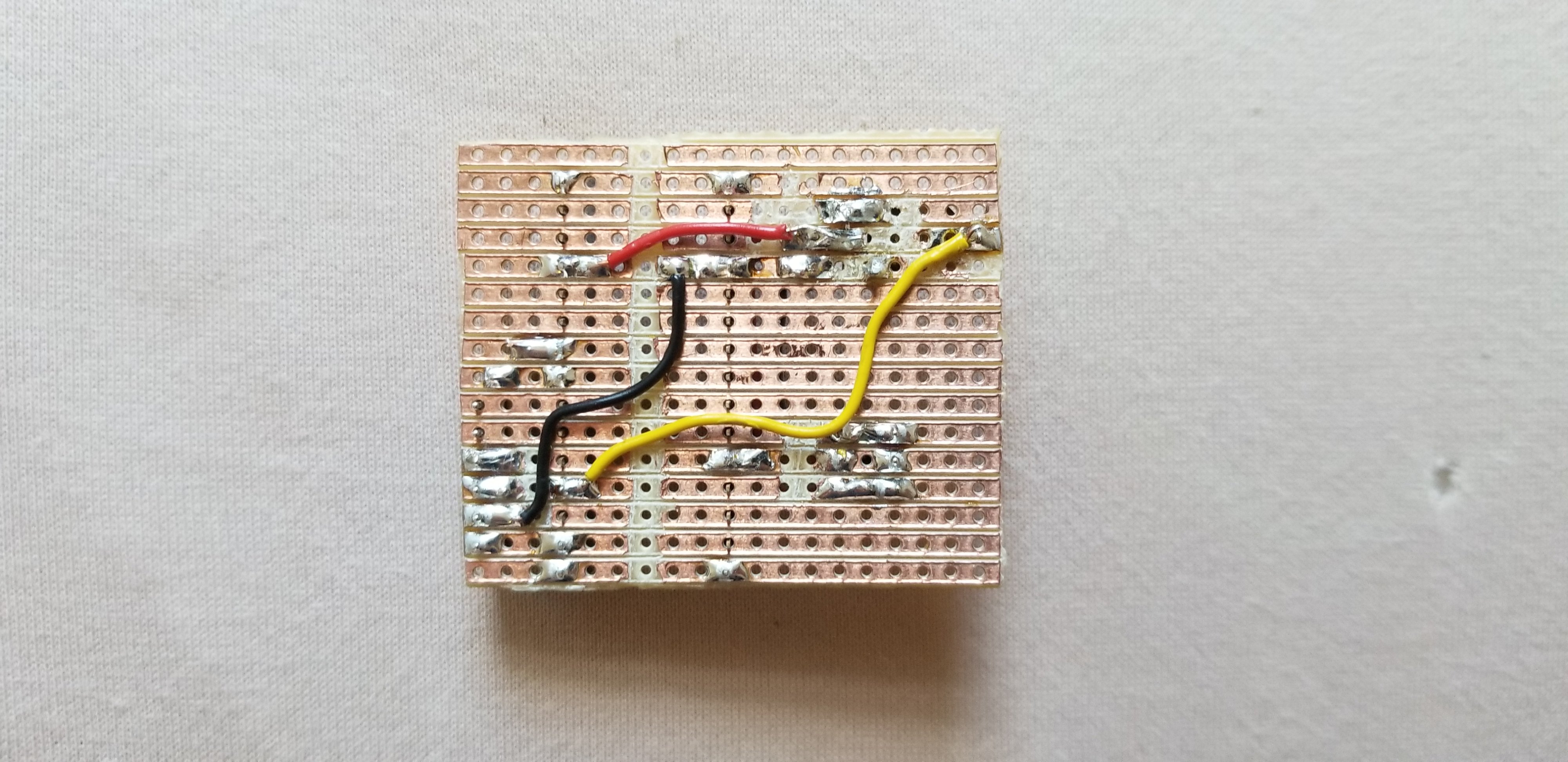

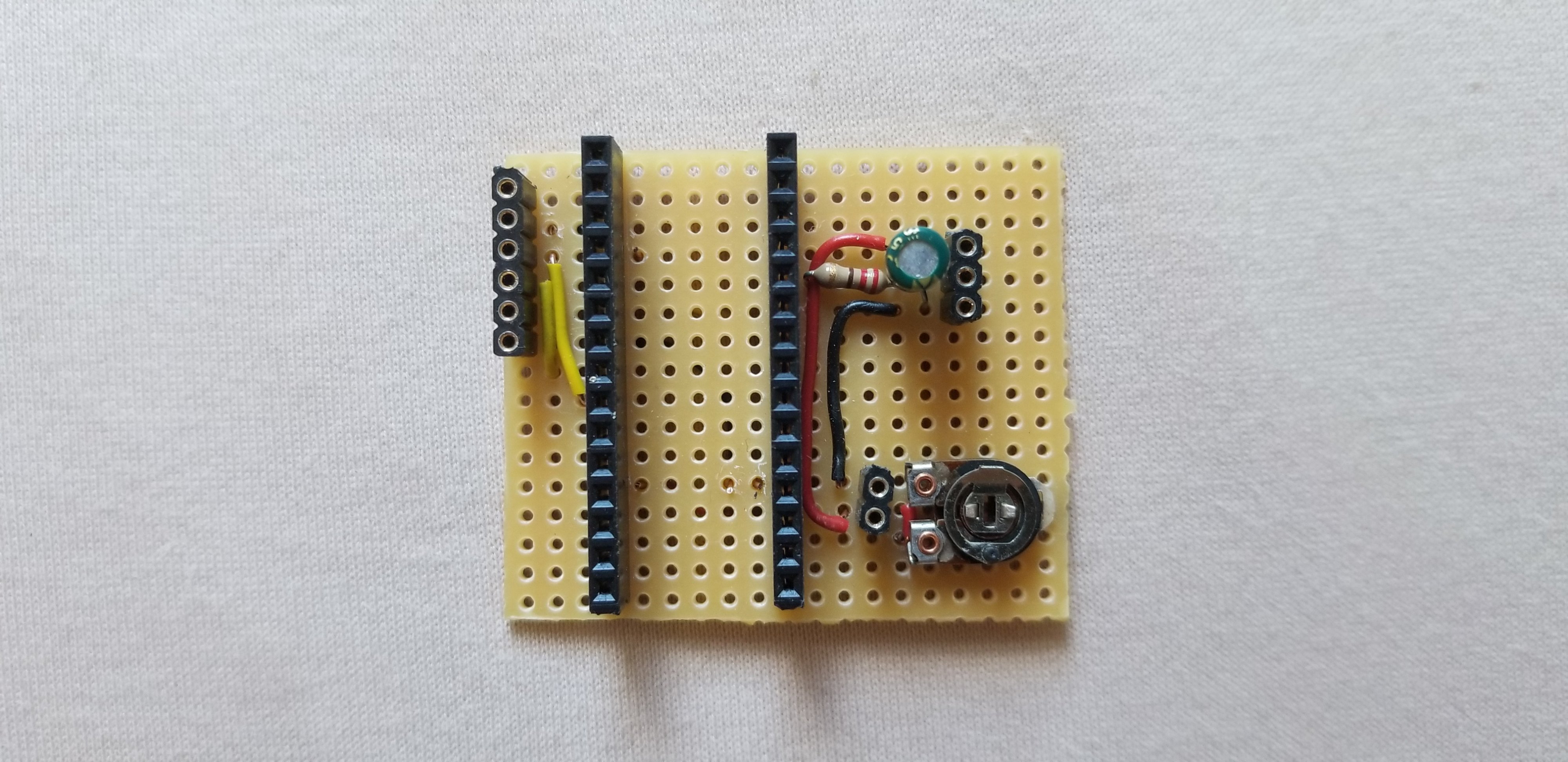

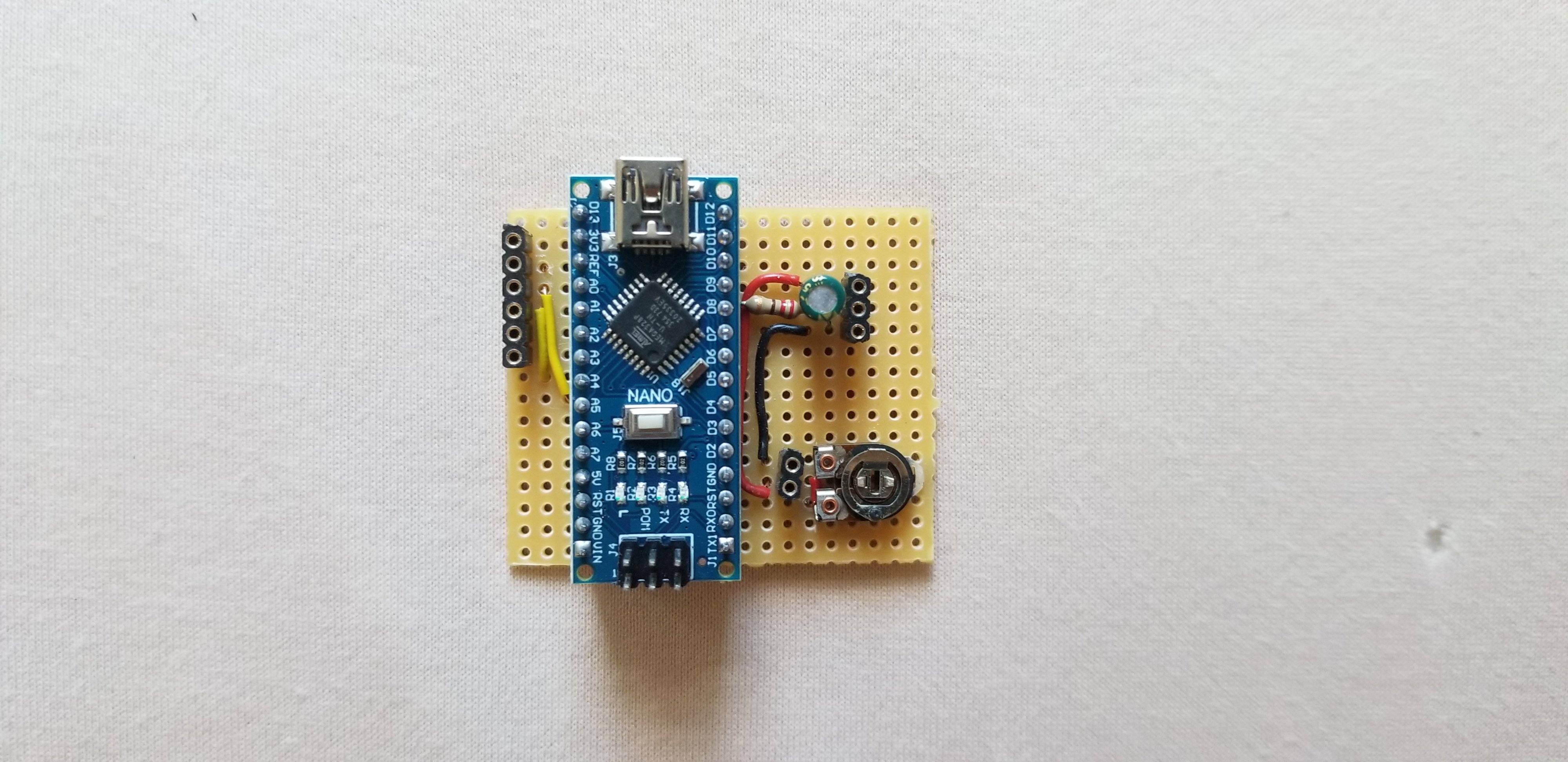

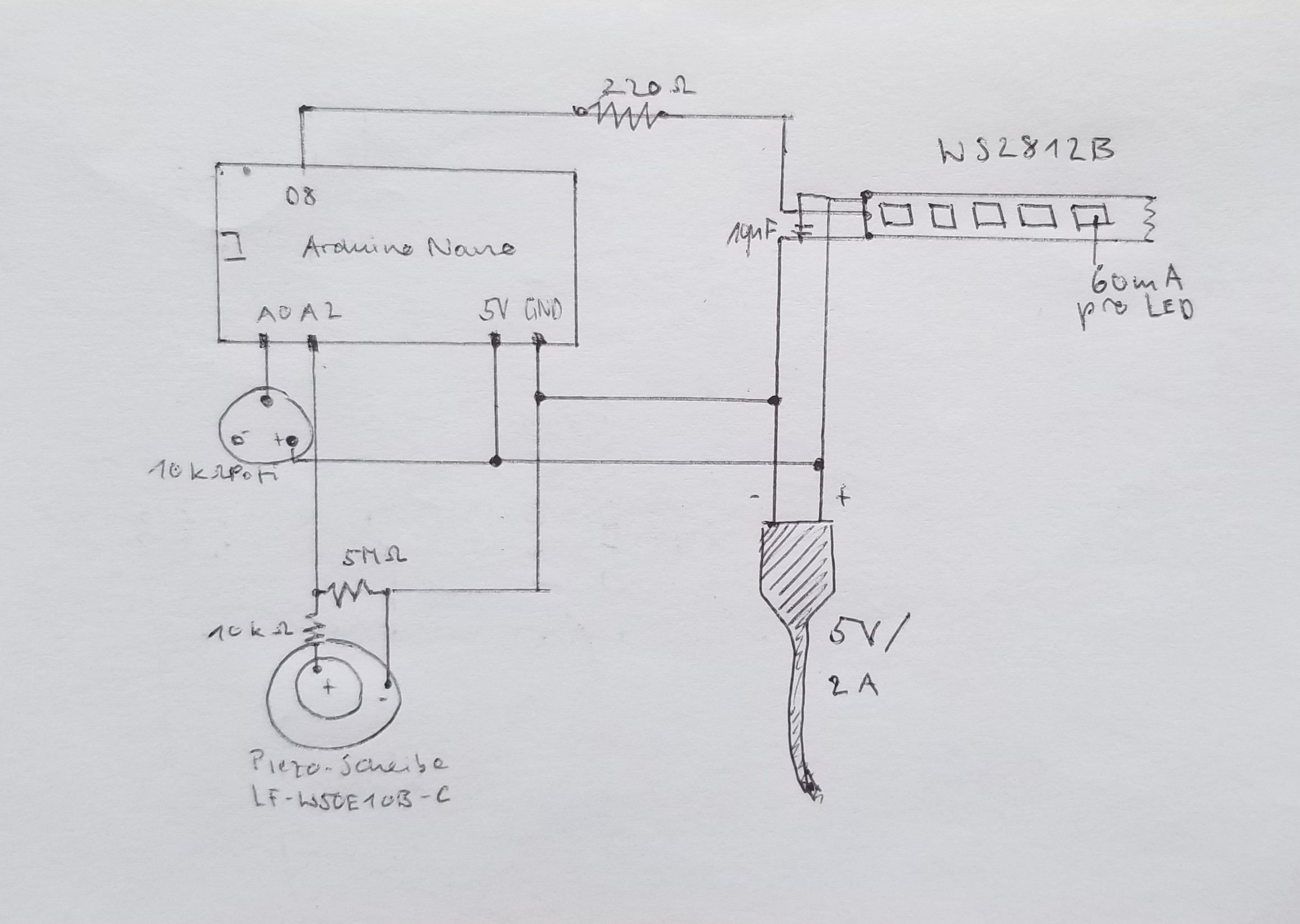

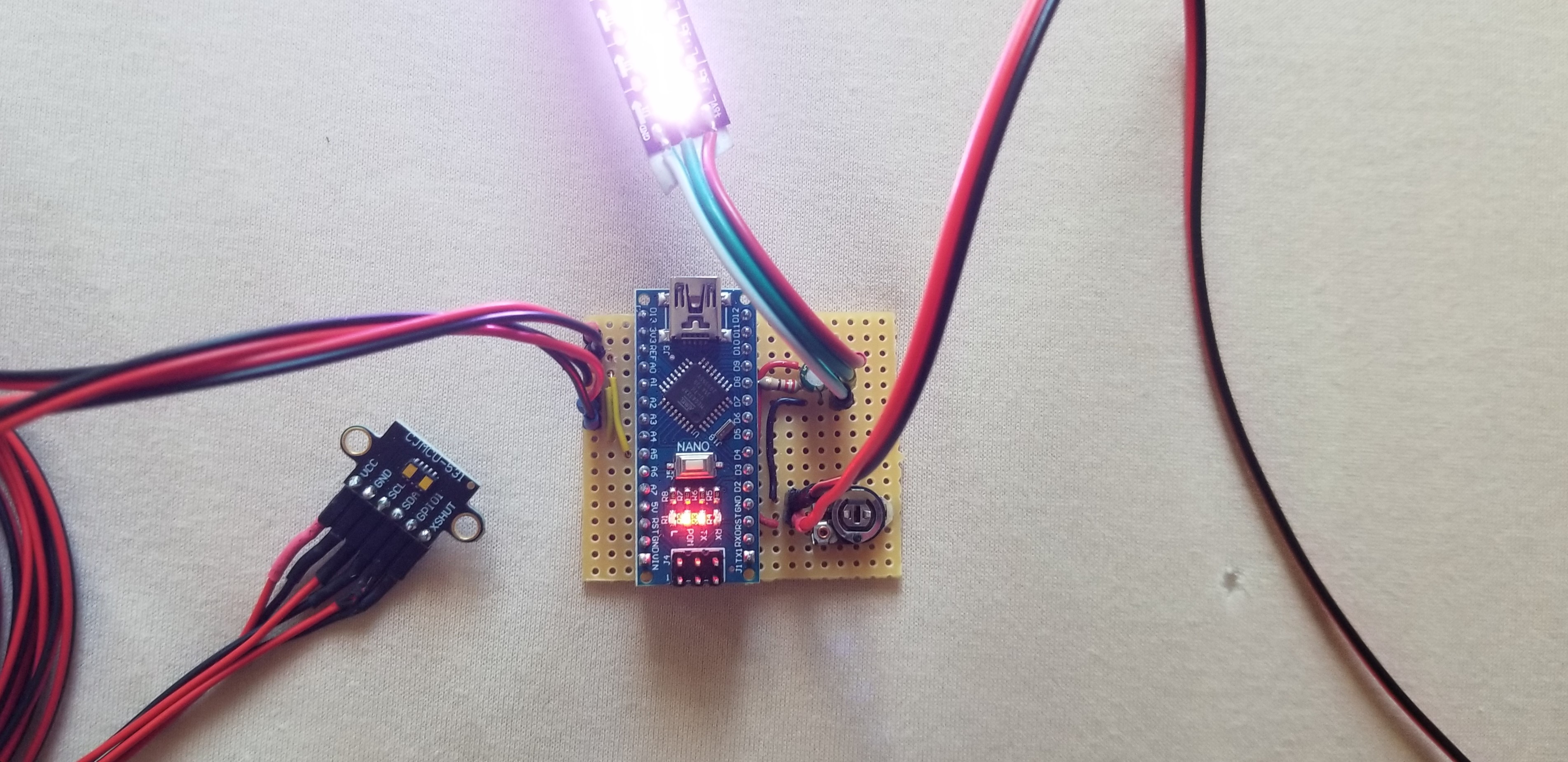

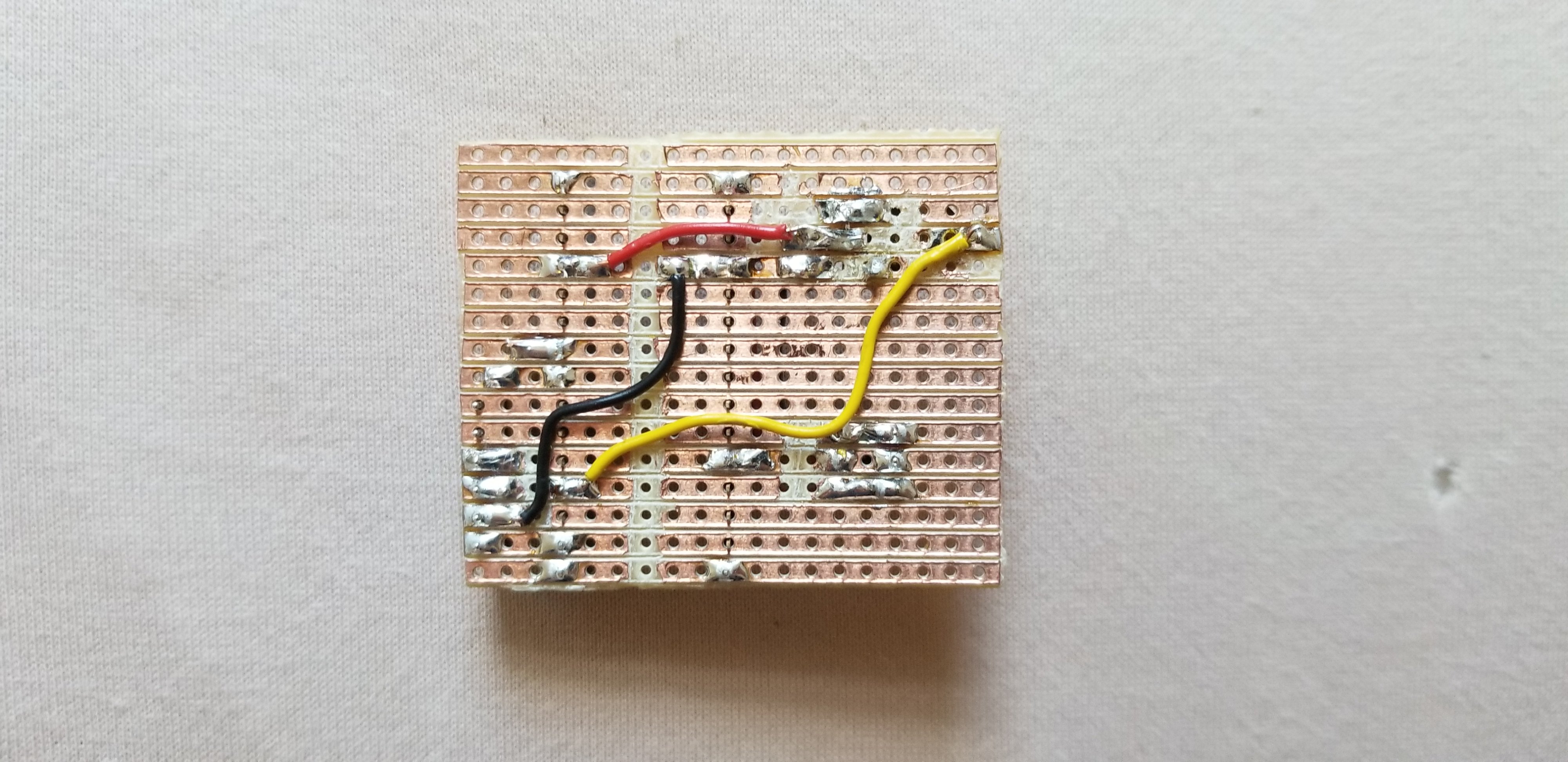

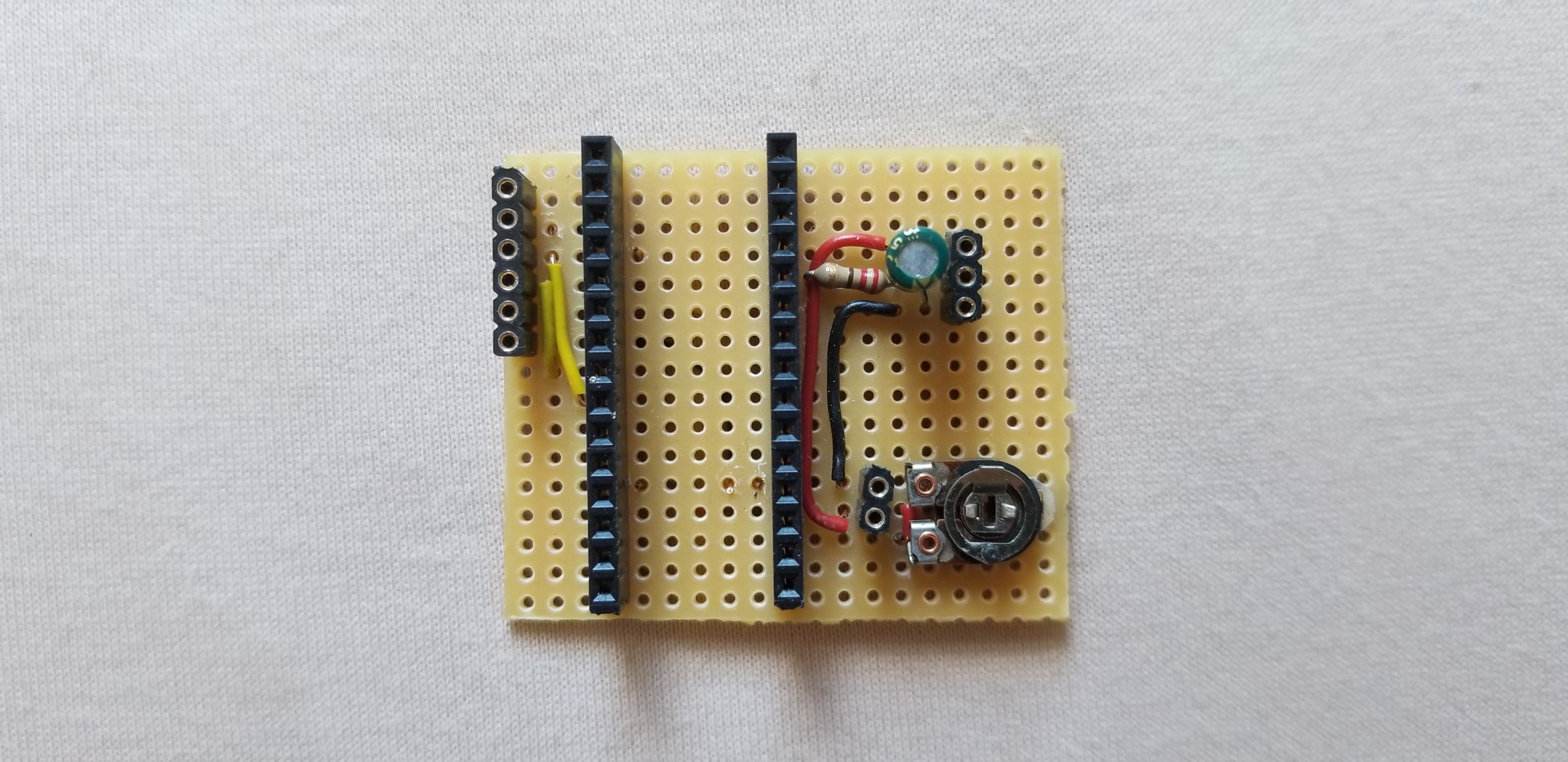

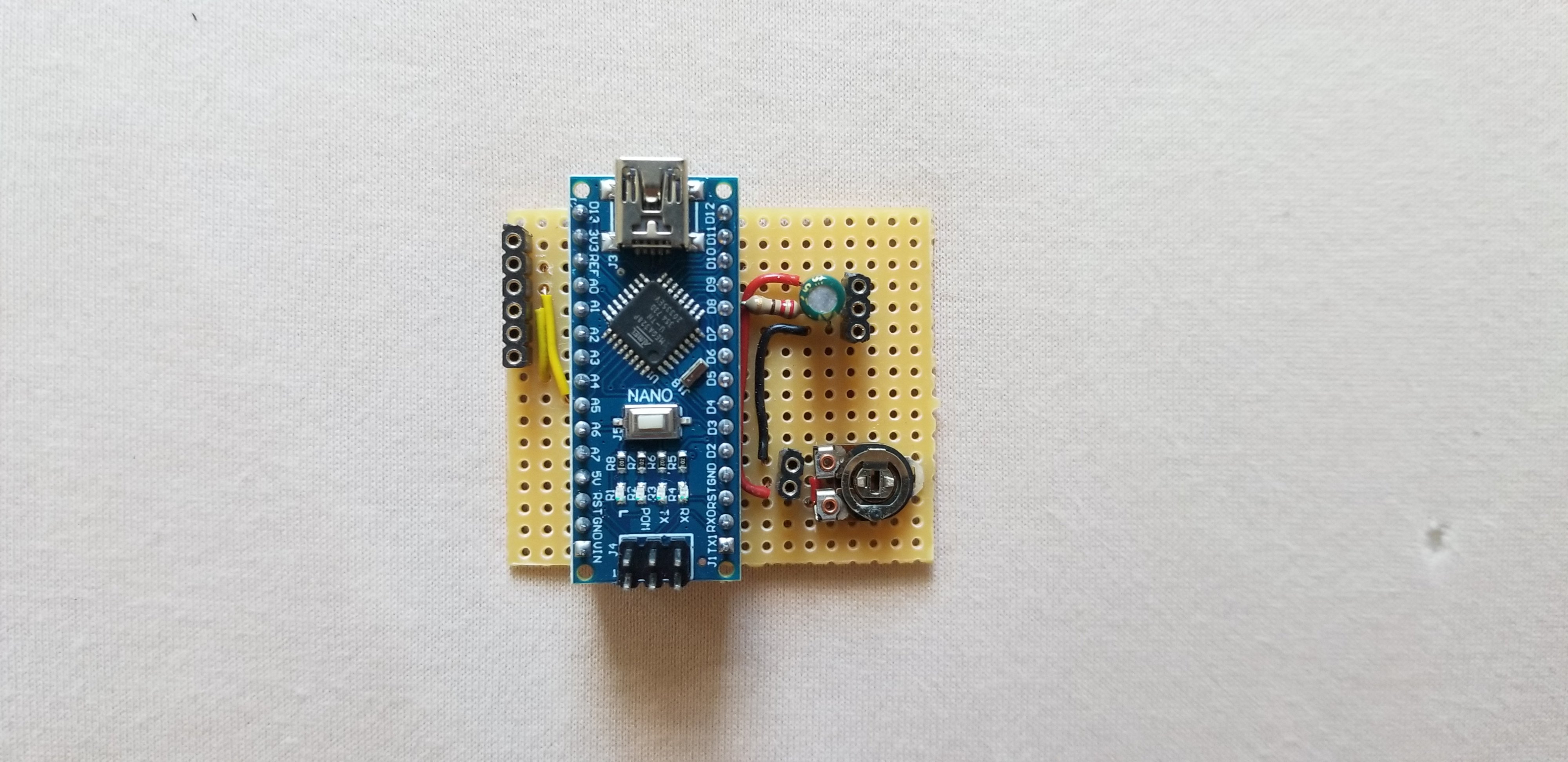

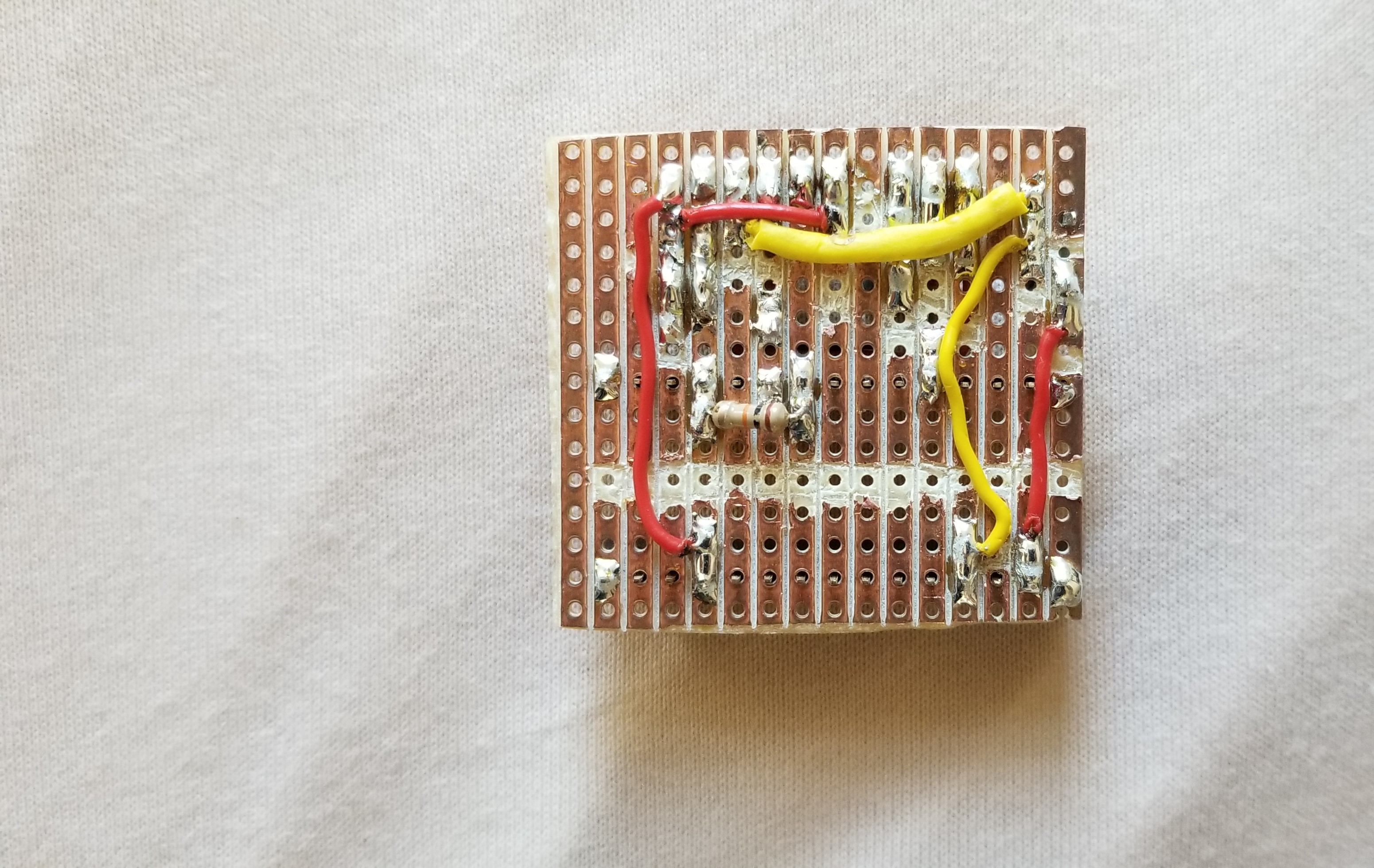

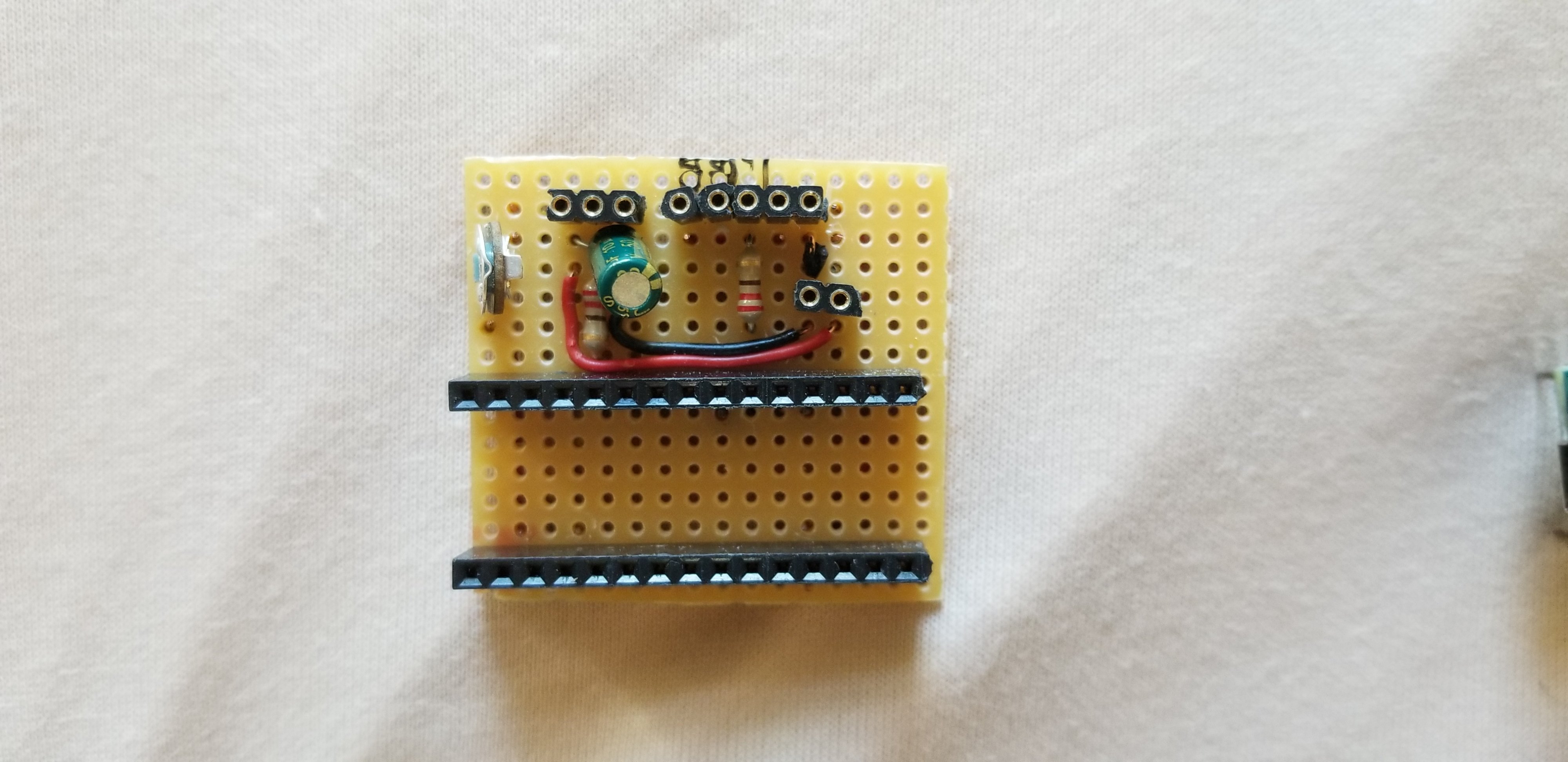

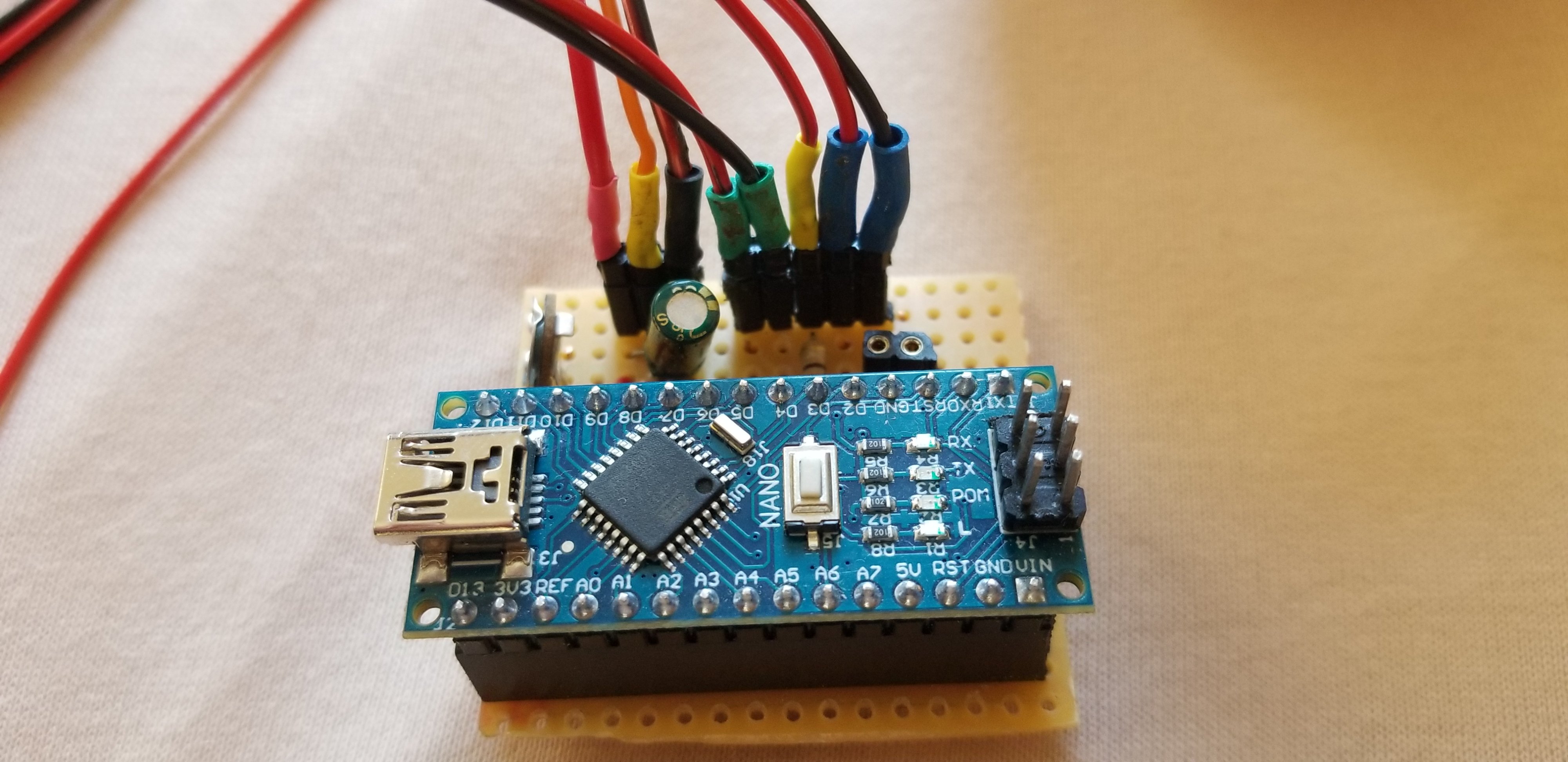

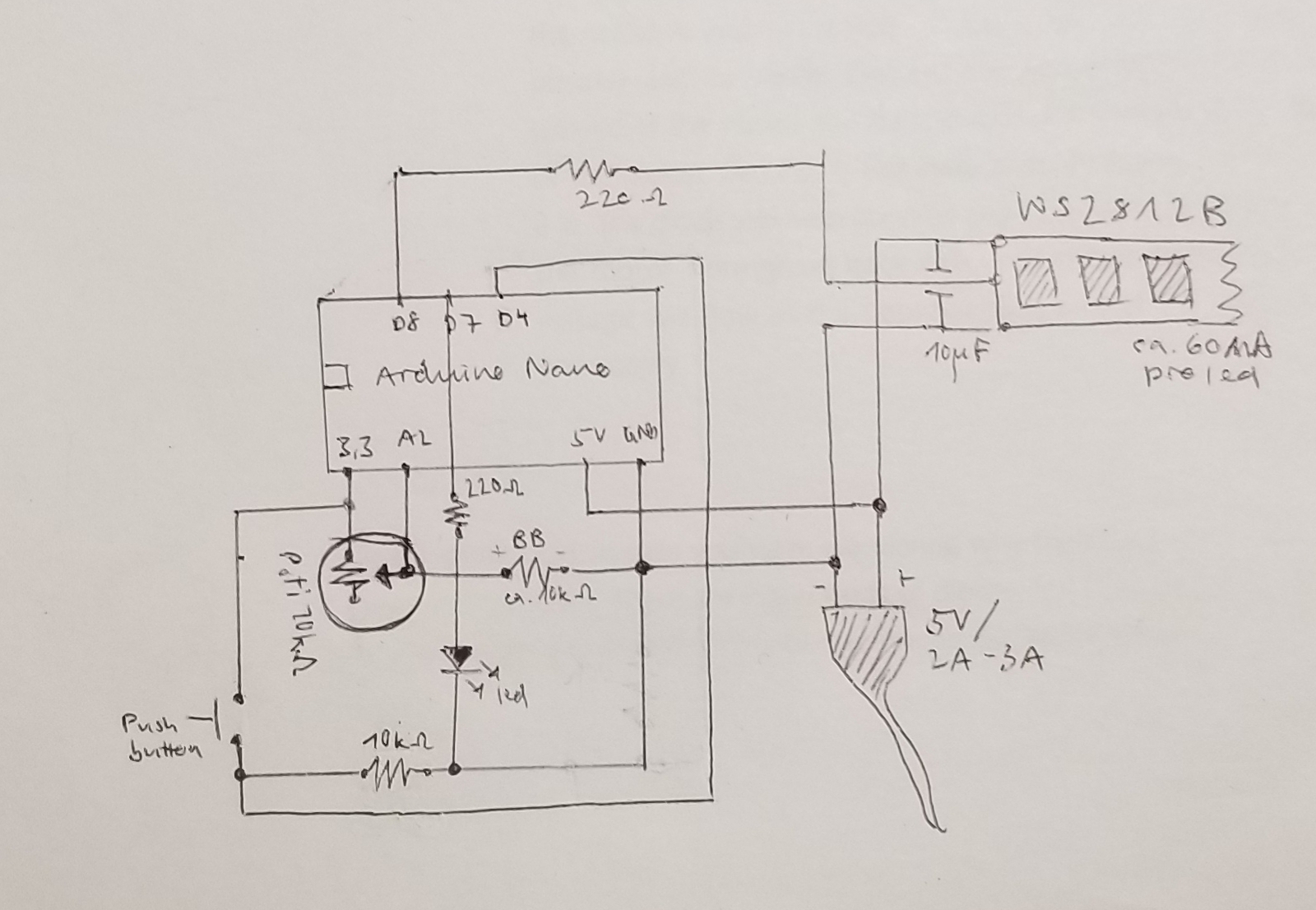

Hier ist die Schaltung zum Anschluss der piezoelektrischen Scheibe an einen Arduino Nano und das Layout auf einem Stripbord. Wie viele Ampere benötigt werden, hängt davon ab, wie viele Leds der verwendete Led-Strip hat(!).

Um den Arduino-Code zum Laufen zu bringen, muss die FastLED-Bibliothek installiert werden. Wenn du einen RingBuffer verwenden möchtest, musst du auch die RingBuffer -Bibliothek installieren…

Zum Code: Code_PiezoLEDs

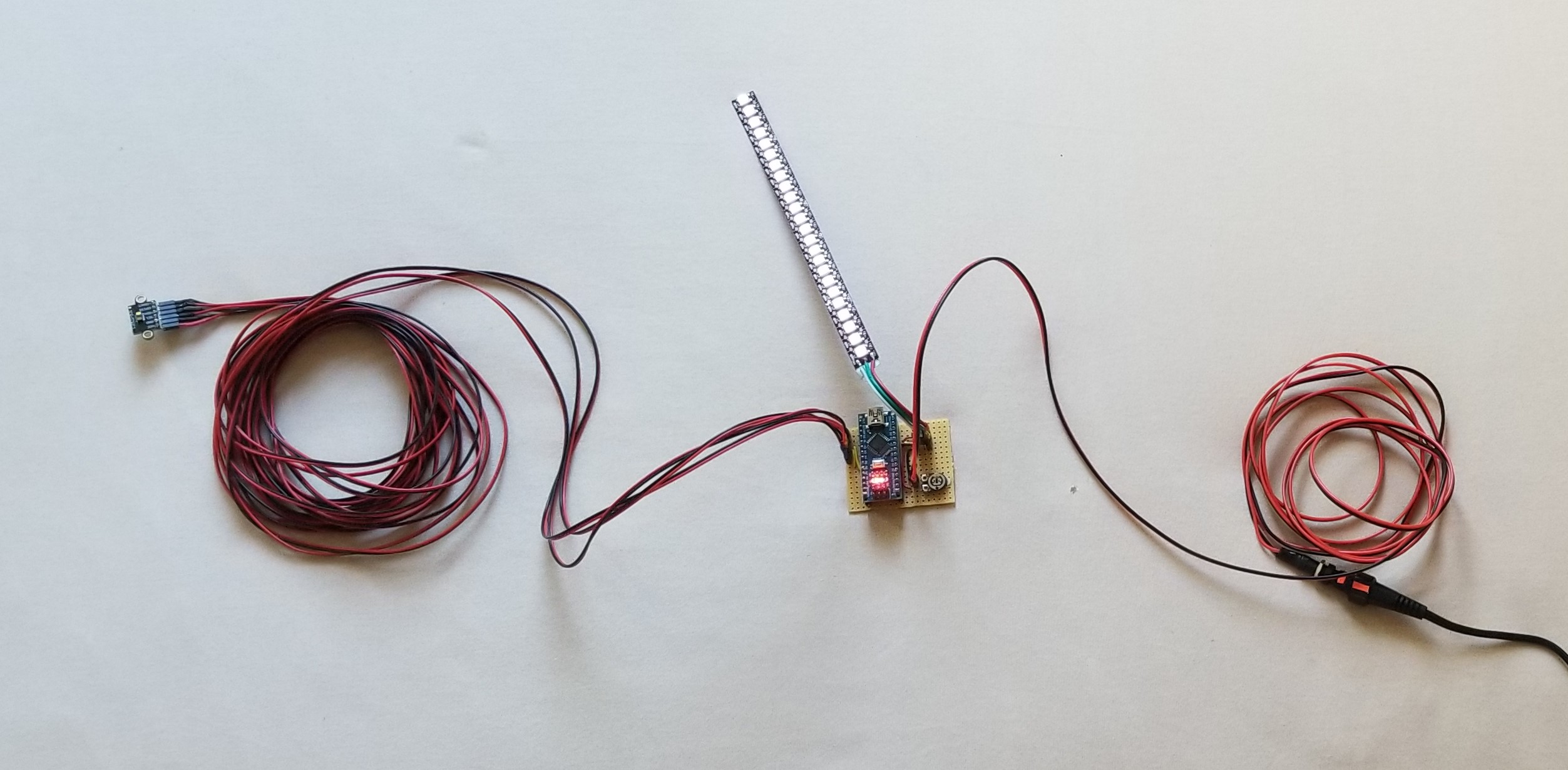

Distanzsensoren

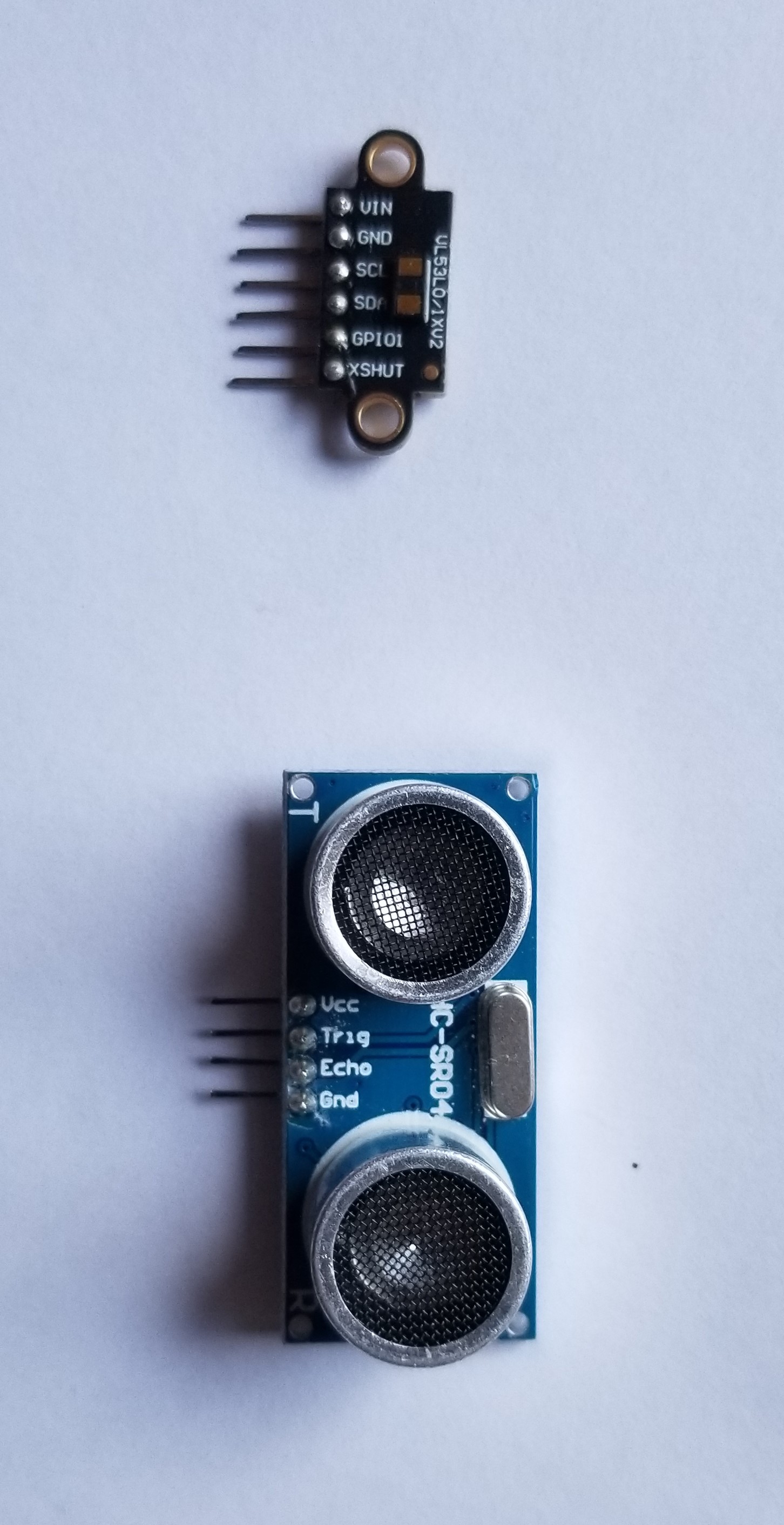

Um die Entfernung zwischen einem Objekt und einer Person zu messen, wird hier ein VL53L1X Sensor verwendet. Es gibt eine günstigere Version, der VL53L0X, der bis zu 200 cm messen kann (je näher, desto genauer). Der VL53L1X ist teurer, hat dafür aber eine grössere Reichweite, die bis zu einer Entfernung von 400 cm misst. Er arbeitet mit einem IR Laser. Der Sensor sendet einen Infrarot Laserstrahl aus, das von der Oberfläche, die es erreicht, abprallt und zum Sensor zurückkehrt, der den Laserstrahl empfängt und die Zeit berechnet, die er braucht, um sich fortzubewegen, wodurch die Entfernung berechnet wird (Time of Flight). Es gibt auch andere Entfernungssensoren wie den HC-SR04, die nach demselben Prinzip arbeiten, aber anstelle eines Infrarotlicht wird ein Ultraschall ausgesendet. Sie sind viel günstiger, jedoch kann es vorkommen, dass eine textile Oberfläche den Ultraschall so ablenkt oder verschluckt, dass er nicht zum Sensor zurückkommt.

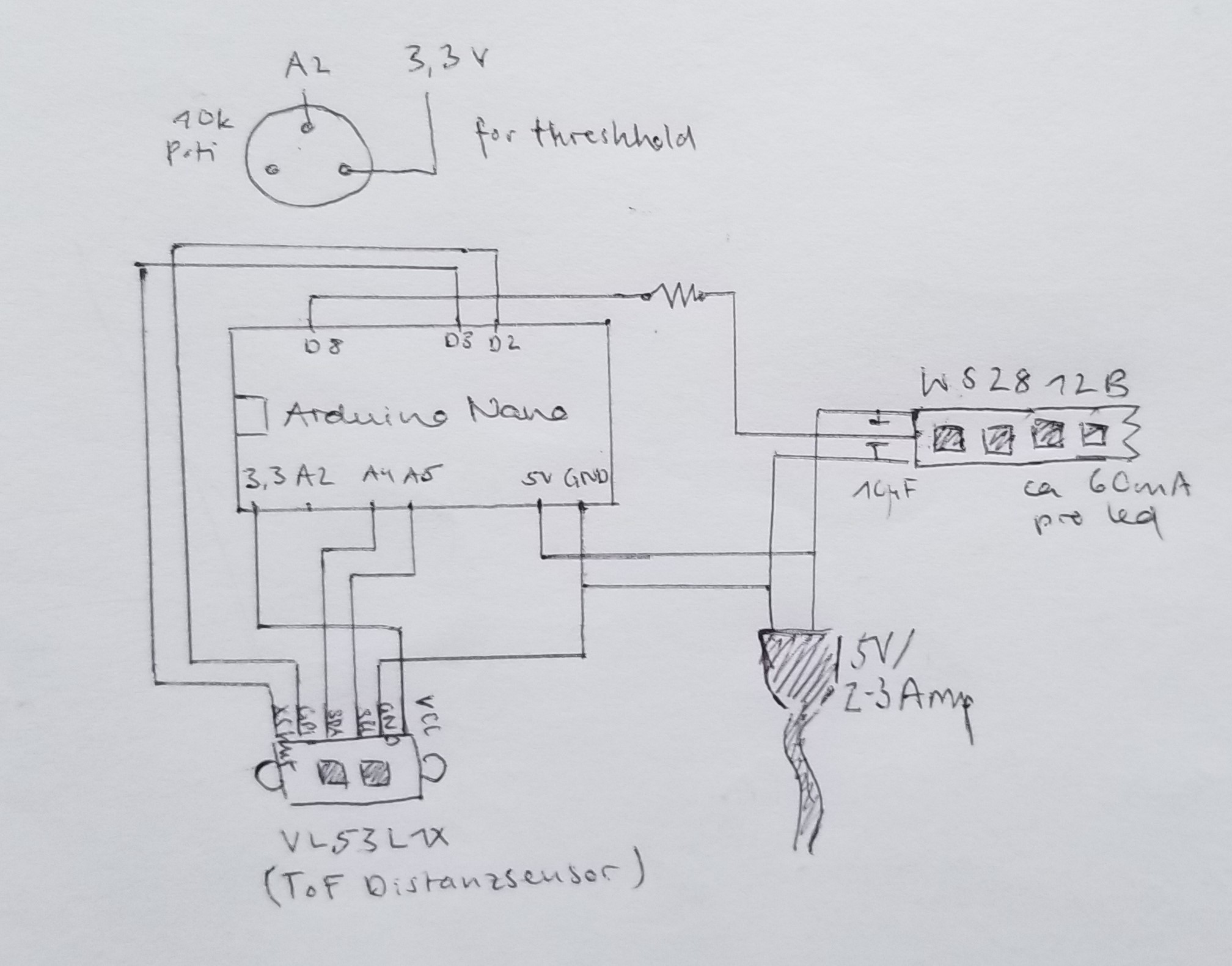

Hier ist die Schaltung zum Anschluss des Abstandssensors an einen Arduino Nano und das Layout auf einem Stripbord. Wenn nur ein Abstandssensor verwendet wird, braucht es den XSHUT Pin (dient zum Ausschalten des Moduls) und den GPIO (Clock Pin) nicht. Wie viele Ampere benötigt werden, hängt davon ab, wie viele Leds der verwendete ledStrip hat(!).

VL53L1X (links), HC-SR04 (rechts)

Um den Arduino-Code zum Laufen zu bringen, muss die FastLED-Bibliothek und die VL53X0L-Bibliothek installiert werden. Zeno Gries hat eine wirklich nette Funktion zur Berechnung des gleitenden Durchschnitts der Sensorwerte geschrieben, wenn mehrere Sensoren im Einsatz sind!

Zum Code: Code_DistanceSensor

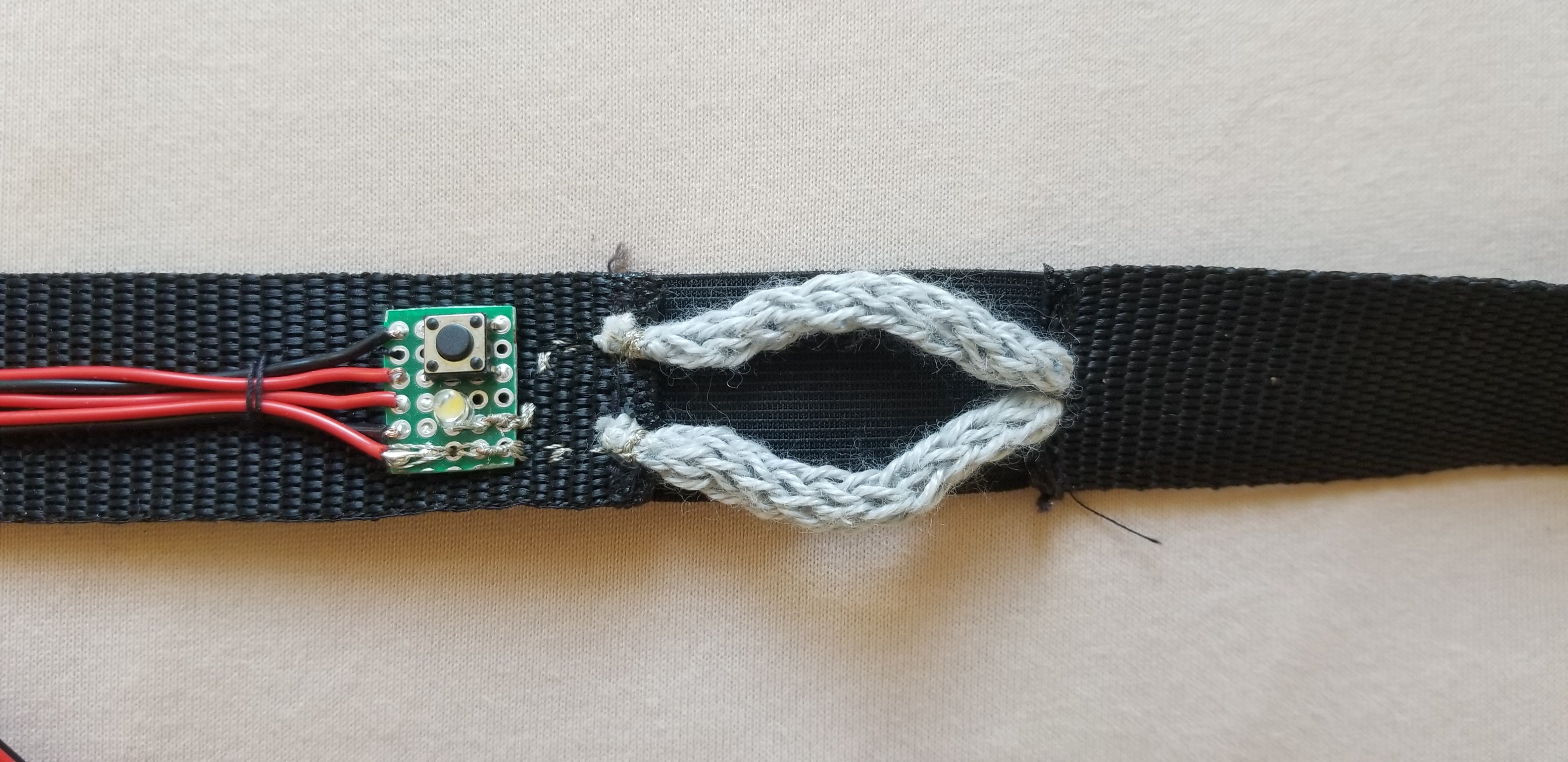

Atemsensor

Um eine direkte Reaktion auf einen Körper im Raum zu erhalten, verwenden wir einen Atemsensor nach dem Entwurf und der Idee von Hannah Perner Wilson. Dieser gehäkelte Dehnungssensor ist eine einfache Lösung, um die Bewegung der Brust- oder Bauchatmung zu erfassen. Dieser Sensor ist aus Edelstahl- und Polyestergarn, dem "Sensorgarn" gestrickt. Eine detaillierte Anleitung zum Bau dieses Sensors gibt es hier: https://www.kobakant.at/DIY/?p=8171

Auf der Website "How to get what you want" von KOBAKANT gibt es noch viele weitere Sensoren zu entdecken.

Ich habe eine Taste hinzugefügt, mit der ein Software-Reset aufgerufen werden kann, um den Sensor auf den eigenen Atem zu kalibrieren. Hier ist die Schaltung zum Anschluss des Atemsensors an einen Arduino Nano und das Layout auf einem Stripbord.

grünes Kabel = pushbutton

gelbes Kabel = led (+)

blaues Kabel = sensor

Um den Arduino-Code zum Laufen zu bringen, muss hier nur die FastLED-Bibliothek installiert werden. Die Software-Reset Funktion kann ebenfalls verwendet werden, ist im Code jedoch auskommentiert.

Zum Code: Code_BB_withCalibrationFunction